Con el reciente anuncio de los nuevos iPhones obtuvimos una serie importante de novedades en cuanto a fotografía, específicamente en los modelos Pro, los cuales incluyen ópticas mejoradas y un software con varias características destinadas a los más dedicados a la fotografía.

Sin embargo, de todas estas novedades, probablemente una de las que más llama la atención es el sensor LiDAR (o Lidar) que viene en estos equipos. Ahora bien, a priori puede sonar como una forma más de poder potenciar el modo retrato del teléfono, pero la verdad es que un sistema bastante interesante.

Por lo mismo, a continuación veremos el cómo funciona y cómo los nuevos iPhone aprovecharán este sensor para el área de la fotografía. Comencemos:

¿Qué es LiDAR?

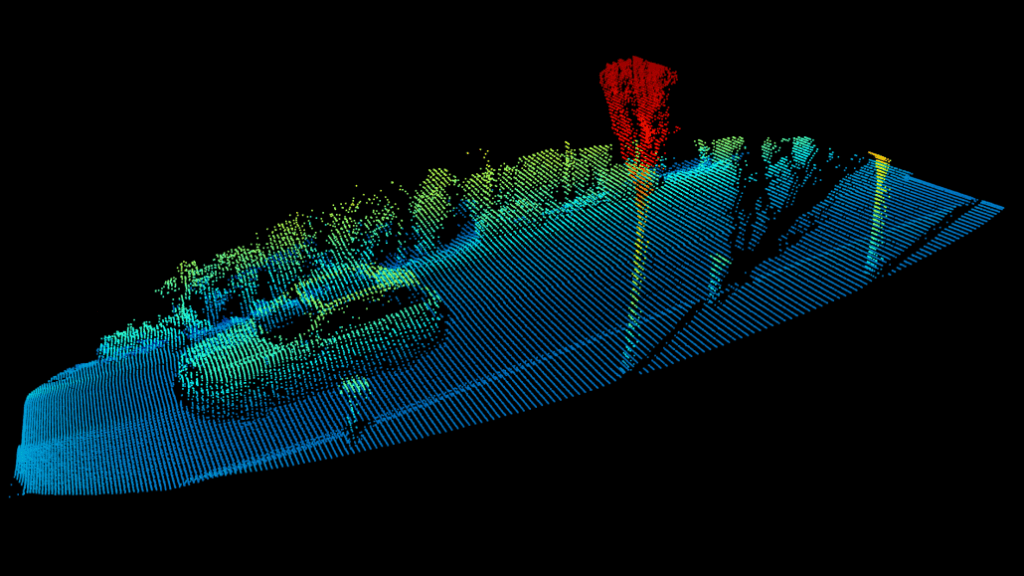

Para partir, quizás es importante mencionar que el Lidar tiene varias aplicaciones en otras industrias o áreas de trabajo, como por ejemplo, para realizar estudios topológicos, estudios geológicos, vehículo autónomos e incluso en los videojuegos, en donde a veces es utilizado por los estudios para poder recrear de manera más fidedigna los distintos circuitos que componen un juego de carreras.

Pero bien, ahora entremos de lleno al tema.

El nombre Lidar es bastante curioso, pues al principio se tomaba como una mezcla de la palabras luz y radar en inglés, pero ahora se entiende como un acrónimo de Light Detection and Ranging o Laser Imaging, Detection and Ranging. Lo importante de esto es que de su nombre podemos saber exactamente lo que hace esta tecnología.

En simples palabras, Lidar es un dispositivo que se utiliza para medir distancias a través del uso de un haz de luz o láser. El funcionamiento es relativamente sencillo, pues consiste en la emisión de este láser, y la medición se hace en base al tiempo en que se demora en volver a su origen.

La medición, por supuesto, es extremadamente rápida. Tanto así que, para nosotros, es prácticamente instantánea, gracias a que estamos trabajando con luz — que es la partícula más rápida del universo. Es sabido que se mueve a una velocidad relativamente constante de aproximadamente 300.000 kilómetros por segundo.

Son varios láseres disparados a la vez — de manera continua o varias veces por segundo — para cubrir la mayor cantidad de superficie posible, y obviamente también funciona cuando tenemos poca o nada de luz disponible.

Ahora, ¿Es lo mismo que un sensor Time-of-Flight (ToF) que utilizan algunos teléfonos? No, los ToF suelen utilizar un solo haz de luz para realizar la medición, por lo tanto, se usa para capturar o medir algo más generalizado, y no es tan preciso como un Lidar.

Además, el verdadero potencial del Lidar, y por el cual es utilizado por en muchas áreas e industrias, es que este permite construir un mapa en tres dimensiones de la superficie que se está midiendo.

Este láser no es visible por el ojo humano y cuenta con una cantidad de energía suficiente como para que no genere daños a la vista por su exposición (como si puede ocurrir con los láser rojos o verdes). Las longitudes de onda utilizadas son del orden de 1500 nanómetros aproximadamente, es decir, están más cerca de los infrarrojos.

Obviamente que el Lidar es mucho más complejo que lo explicado aquí, pero para el objetivo de este artículo, basta y sobra. Ahora, veamos como Apple planea utilizarlo en los nuevos iPhone.

¿Cómo funciona en los iPhone?

El iPhone 12 Pro no es el primer dispositivo de Apple que cuenta con este sensor, de hecho, el título se lo queda la más reciente versión del iPad Pro — presentado hace unos muchos años 6 meses atrás.

El propósito del LiDAR en el iPad Pro fue, principalmente, para potenciar aún más el ecosistema de realidad aumentada — ARKit — que Apple ha estado construyendo durante los últimos años. Desde aplicaciones para realizar mediciones, pasando por servicios de AR para ver cómo puede quedar cierto mueble que queramos comprar, hasta incluso por videojuegos, como es el caso de Minecraft Earth.

Para los iPhone 12 Pro, Lidar tendrá como trabajo adicional el apoyar a la cámara en diversas situaciones que lo requiera.

El ejemplo más obvio es el modo retrato. Con la precisión que ofrece el Lidar, el teléfono será capaz de poder detectar de mejor manera los bordes, resultando en un efecto de desenfoque/bokeh mucho más parecido al que te puede ofrecer una cámara réflex con un objetivo ideal para capturar retratos.

Otro de los beneficiados es la fotografía nocturna. Aparte de que el modo retrato ahora podrá funcionar en conjunto con el modo noche, el Lidar también servirá como apoyo para el sistema de autoenfoque, el cual, según Apple, ahora es hasta seis veces más rápido en situaciones de baja luminosidad. Estas mejoras, por supuesto, se ven potenciadas en parte gracias al nuevo procesador A14 Bionic y a iOS 14.

Habiendo dicho esto, por el momento solo queda ver cómo funciona este sensor en los nuevos iPhone 12 Pro, y ver si es que realmente hace una diferencia en comparación a los modelos anteriores. Esto, de todas maneras, será uno de los focos principales que tendremos en cuenta al momento de realizar el análisis de estos dispositivos.