ChatGPT o1 superó a una serie de científicos en el examen Graduate-Level Google-Proof Q&A Benchmark demostrando asombro.

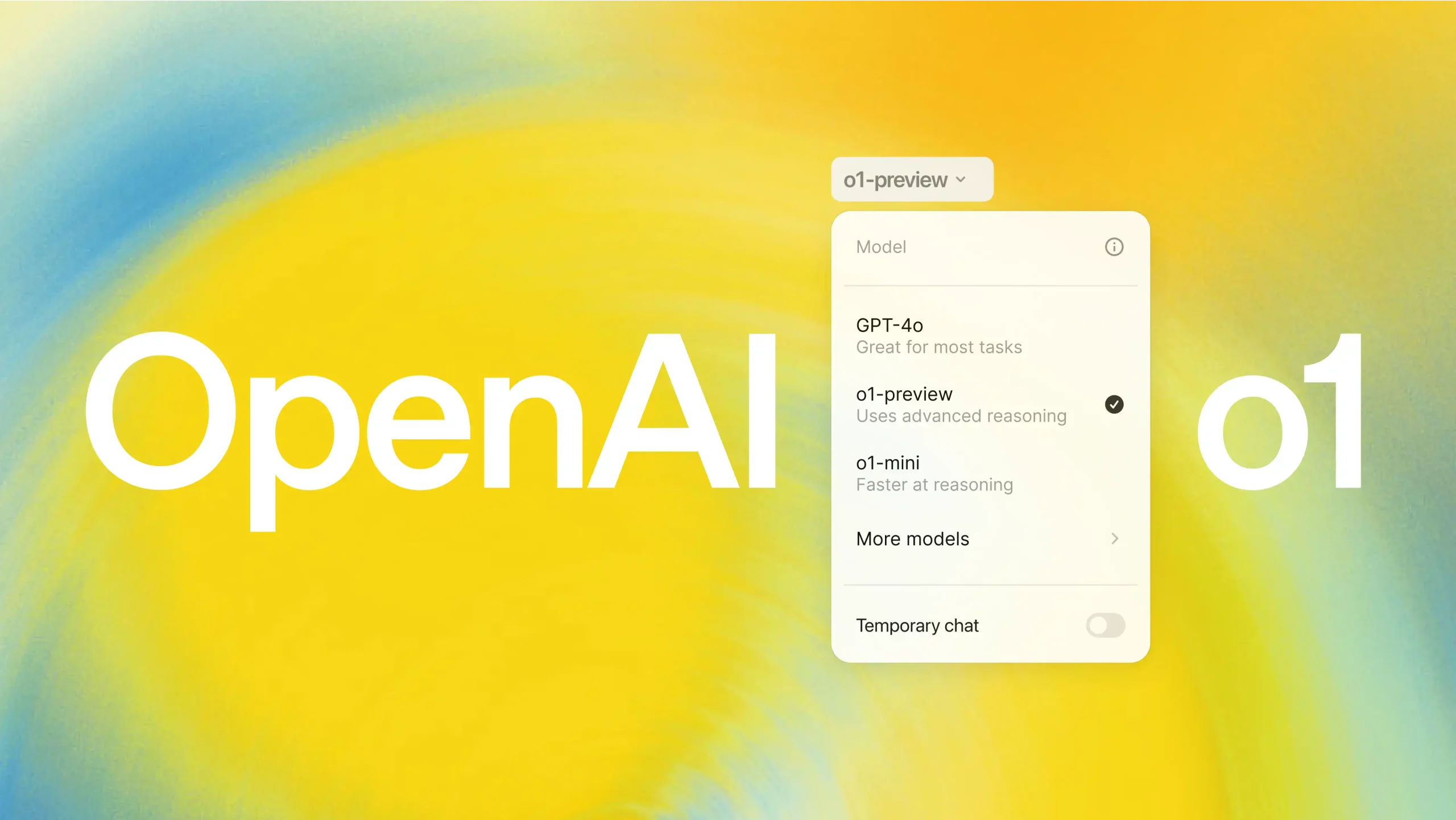

ChatGPT o1 ha sido lanzado recientemente por OpenAI como el nuevo gran modelo de lenguaje, y está cumpliendo a cabalidad todo lo que se ha prometido, y es que incluso en un examen de ciencias duras contra científicos con grado de doctorado ha salido airoso.

Específicamente, este modelo de ChatGPT o1 se ha convertido en el primer modelo de lenguaje de gran tamaño que supera a los estudiantes de doctorado en el conjunto «diamante» de preguntas en una prueba denominada Graduate-Level Google-Proof Q&A Benchmark (GPQA).

OpenAI afirmó que sus alumnos obtuvieron una puntuación ligeramente inferior al 70% en el examen GPQA Diamond, mientras que el modelo o1 obtuvo un 78% en total. Además, obtuvo una puntuación especialmente alta del 93% en física.

Se trata de una puntuación significativamente superior a la del siguiente chatbot con mejor rendimiento. Pero no todo termina aquí, y es que OpenAI también probó o1 en un examen clasificatorio para la Olimpiada Internacional de Matemáticas. Así, el modelo GPT-4o solo resolvió correctamente el 13% de los problemas, pero el modelo o1 obtuvo un 83% de respuestas correctas.

Todo esto levanta optimismos por el futuro de los modelos de lenguaje, pero también enciende as alarmas por los riesgos. Y es que es mucha la gente que no puede discernir entre IA y humanos aún. Y justamente ahí es donde está el problema actualmente a superar en el futuro

Fuente: Nature