Zyphra, empresa de investigación en IA Open Source, acordó con IBM y AMD la implementación de infraestructura de entrenamiento de gran escala en IBM Cloud.

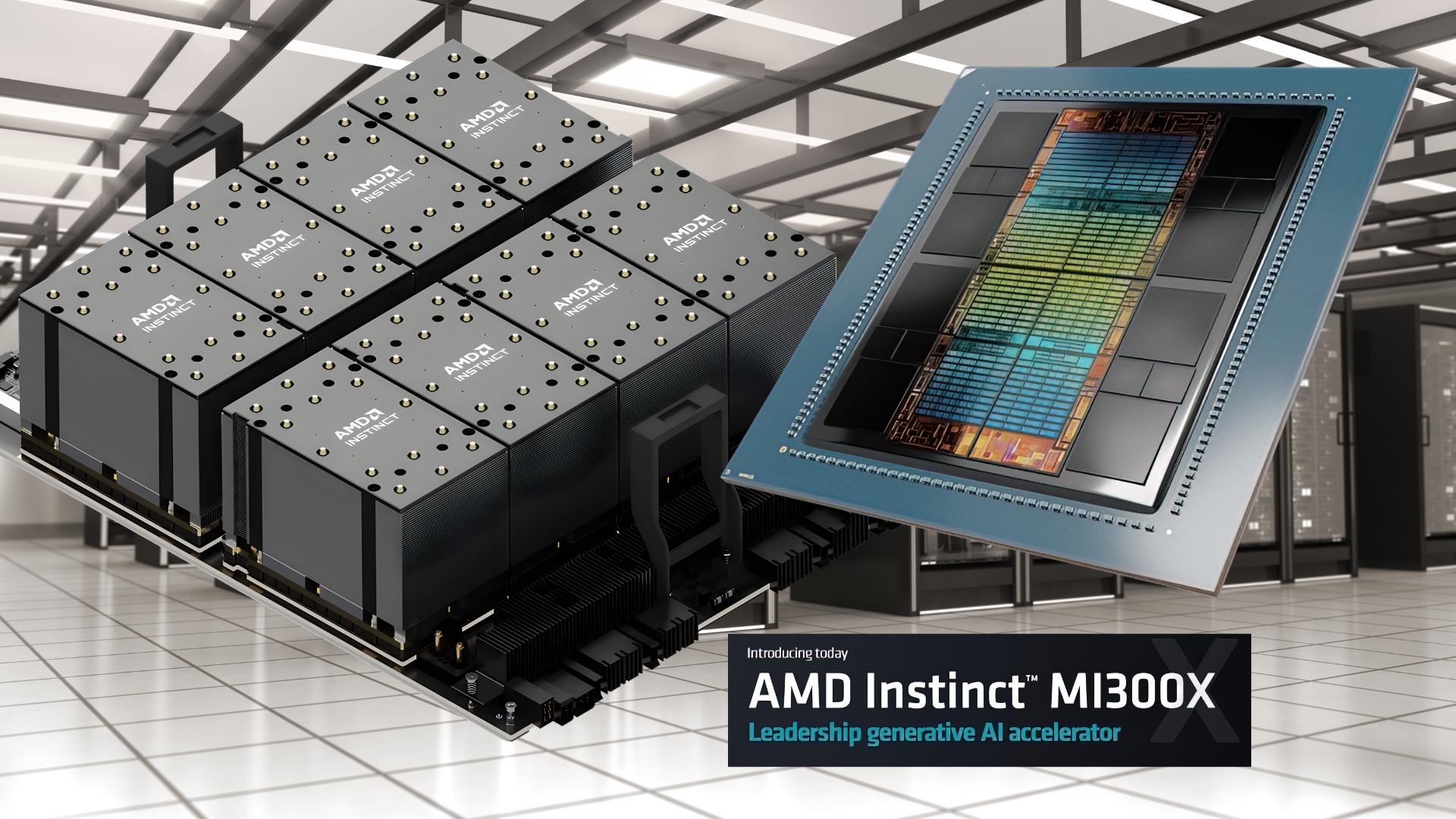

El proyecto contempla un clúster de GPUs AMD Instinct MI300X destinado al desarrollo de modelos fundacionales multimodales en lenguaje, visión y audio.

Nota editorial: Un modelo funcional multimodal es un sistema de IA capaz de procesar y combinar distintos tipos de datos, como texto, imágenes, audio o video, para generar una comprensión más completa y contextualizada de la información.

¿Para qué usará Zyphra la infraestructura en IBM Cloud con GPUs AMD?

La compañía planea utilizar este entorno para acelerar el desarrollo de Maia, un superagente diseñado para avanzar en el entrenamiento de modelos multimodales que integren lenguaje, visión y audio, con capacidad de escalar a medida que aumenten las demandas de cómputo.

La alianza entre las tecnológicas permitirá que Zyphra realice sus investigaciones y desarrollos de nuevas arquitecturas de redes neuronales para aprendizaje continuo y memoria de largo plazo.

Este clúster (grupo de servidores) marca el primer entrenamiento dedicado en IBM Cloud basado exclusivamente en un ecosistema de GPUs de AMD. Esta es una infraestructura dedicada a maximizar modelos de IA generativa y aplicaciones de alto rendimiento, aprovechando las capacidades de seguridad, escalabilidad y confiabilidad de IBM Cloud.

¿Qué es Maia?

Maia es un superagente de propósito general en desarrollo por Zyphra, diseñado como una plataforma de inteligencia artificial multimodal.

- Capaz de trabajar con múltiples tipos de datos.

- Integra lenguaje, visión y audio en un mismo sistema.

- Permite ejecutar tareas complejas con mayor contexto.

El proyecto incorpora mecanismos que buscan darle a Maia capacidades de adaptación y evolución a lo largo del tiempo.

- Incluye memoria a largo plazo.

- Integra aprendizaje continuo.

- Puede adaptarse a nuevas experiencias y datos.

- Desarrolla estrategias flexibles más allá de instrucciones predefinidas.

El hardware detrás de Maia

El entrenamiento de Maia se realizará en infraestructura de gran escala para potenciar sus capacidades.

- Entrenado en IBM Cloud.

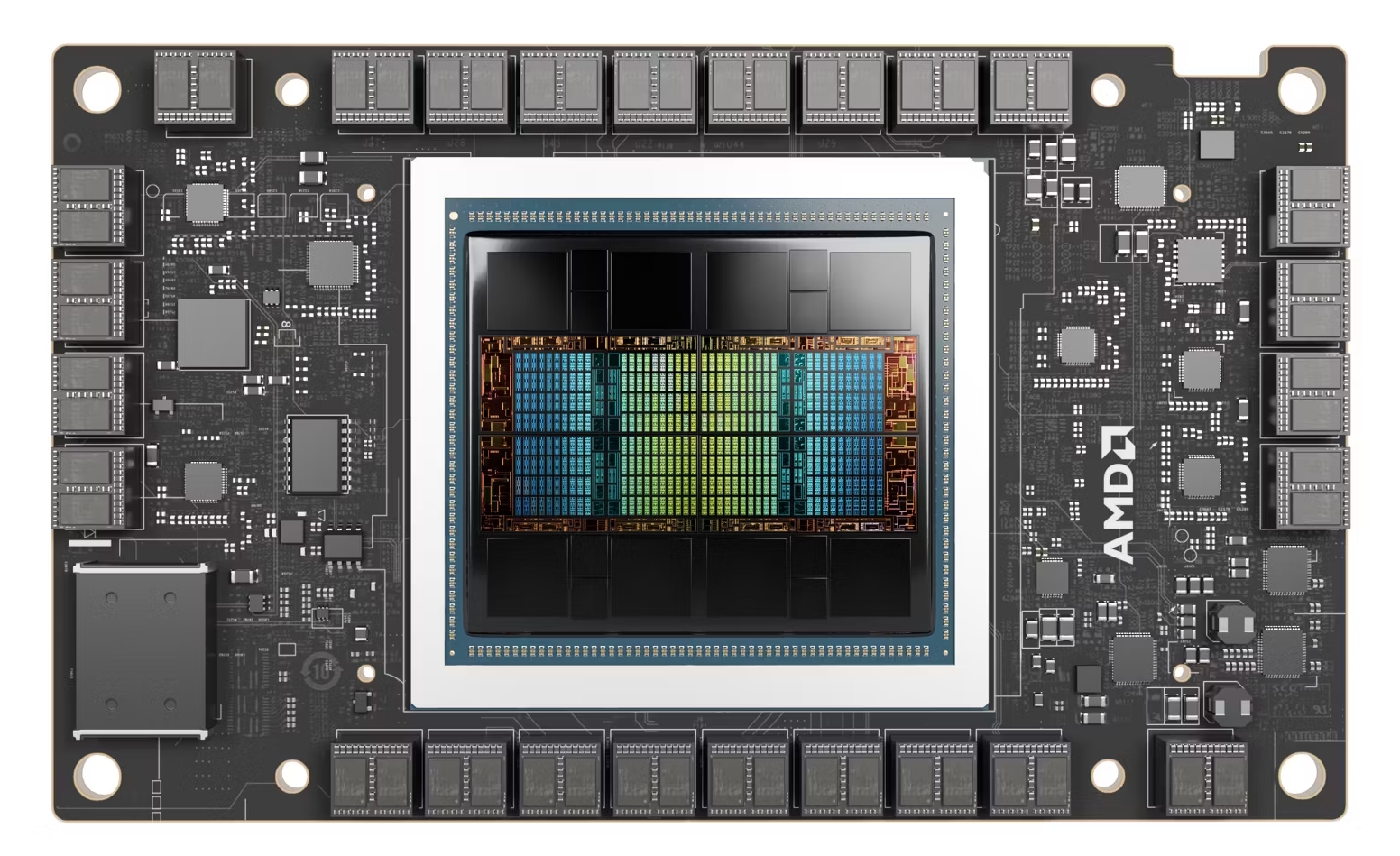

- Utiliza GPUs AMD Instinct MI300X.

- Soportado con infraestructura de red y aceleración de AMD.

- Permite explorar arquitecturas neuronales avanzadas.

- Facilita la construcción de representaciones multimodales de información.

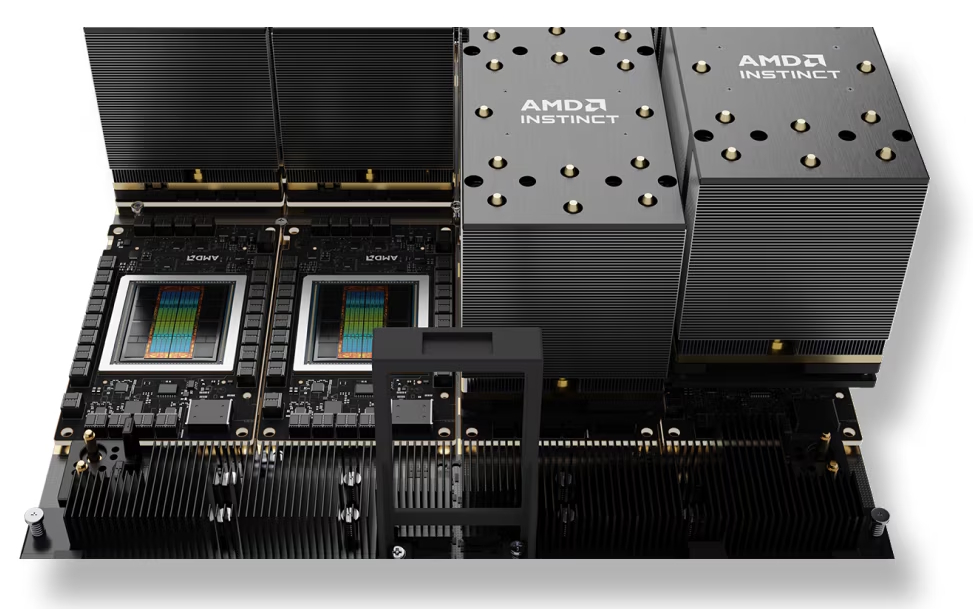

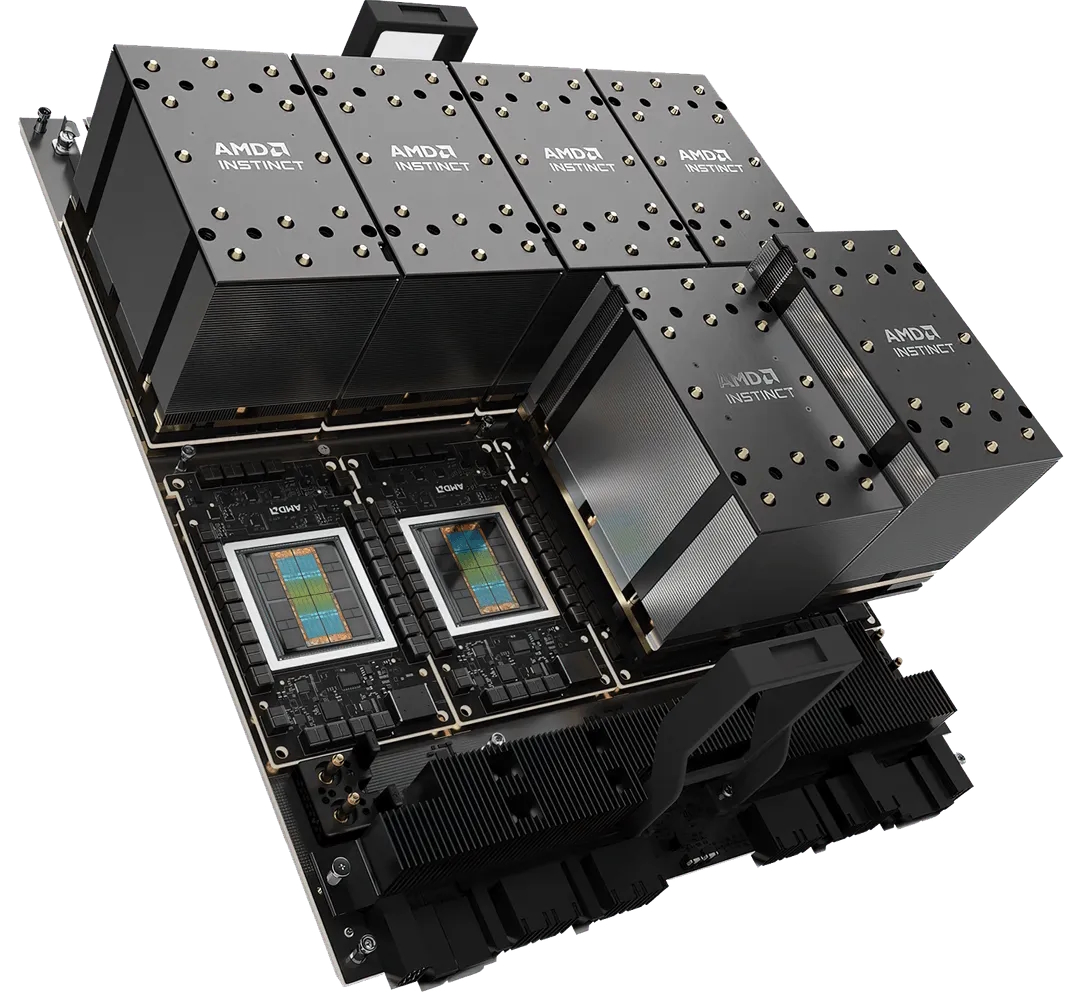

El conjunto de 8 de estos módulos genera un nodo de cómputo, como se ven las siguientes imágenes:

La siguiente imagen de SuperMicro, muestra un conjunto de nodos de GPU AMD MI300X con un sistema de enfriamiento por aire que ocupa de 6 a 8 U en el gabinete.

La infraestructura incluye no solo las GPUs MI300X, sino también las tarjetas de red inteligentes AMD Pensando Pollara 400 AI NICs y las AMD Pensando Ortano DPUs, configuradas para optimizar la transferencia de datos y el rendimiento en cargas de trabajo intensivas de inteligencia artificial.

Con esta hoja de ruta, IBM y AMD consolidan su colaboración en tecnologías que combinan rendimiento clásico y cuántico, orientadas al desarrollo de una nueva generación de infraestructura para inteligencia artificial.