A comienzos de este mes, OpenAI, durante el lanzamiento de ChatGPT 5.0, mencionaba que la herramienta de IA tiene más de 700 millones de usuarios a la semana, y más de 5 millones usan la versión de pago. Sin embargo, medios reportan el creciente auto de psicosis por IA.

Herramientas como los chatbots, se consideran útiles porque facilitan las tareas repetitivas, y otras tediosas. Los medios están dando a conocer que reportes de personas que, tras largas conversaciones con la IA, desarrollan creencias delirantes, vínculos emocionales intensos o incluso episodios psicóticos.

Casos clínicos y psiquiátricos vinculados a “psicosis por IA”

El Washington Post reportó que usuarios de chatbots están desarrollando creencias difíciles de comprobar, y lo que es peor, en algunos casos se aprecian paranoias o relaciones emocionales intensas con los modelos de AI. Así lo asegura la profesora adjunta de psiquiatría, Stanford School of Medicine, Ashleigh Golden:

«Creamos esta expresión cuando notamos un problema serio: los chatbots comenzaron a seguirles la corriente a usuarios que tenían ideas delirantes sobre ser mesías, personas súper importantes, tener misiones divinas, o estar en relaciones románticas imaginarias».

Ashleigh Golden, profesora adjunta de psiquiatría, Stanford School of Medicine

Golden se refiere a que el problema no radica solo en el contenido de las conversaciones, sino también en la dificultad de algunos usuarios para establecer límites claros entre la realidad y lo que experimentan en su interacción con la IA.

Los expertos en salud mental están preocupados por cómo los chatbots pueden reforzar ideas delirantes. Como señala Jon Kole, psiquiatra y director médico de Headspace:

«La dificultad común es distinguir qué es real y qué no. Eso podría significar que una persona forme creencias que pueden demostrarse falsas, o que desarrolle una relación intensa con una IA que no coincide con lo que está ocurriendo en la vida real».

Jon Kole, psiquiatra y director médico, Headspace

Por su parte, el psiquiatra Keith Sakata, de la Universidad de California en San Francisco, informó que este año ha hospitalizado a una docena de pacientes tras un uso excesivo de chatbots. Muchos llevaron consigo transcripciones de sus interacciones como “pruebas” de sus creencias.

«La IA puede validar pensamientos dañinos o negativos para personas con condiciones como TOC, ansiedad o psicosis, lo que puede crear un ciclo de retroalimentación que empeora sus síntomas o los hace inmanejables. Creo que la IA probablemente no está causando que las personas desarrollen nuevas condiciones, pero puede servir como el ‘copo de nieve que desestabiliza la avalancha’, enviando a alguien predispuesto a enfermedades mentales por el borde«.

Kevin Caridad, psicoterapeuta y CEO, Cognitive Behavior Institut

El fenómeno preocupa porque no se limita a personas con diagnósticos previos. Expertos insisten en que se trata de un área en rápido crecimiento que requiere investigación y protocolos de salud mental.

Advertencia corporativa y ética sobre IA que “parece consciente”

En Fortune, Mustafa Suleyman, CEO de Microsoft AI y cofundador de DeepMind, advirtió que el mundo podría estar al borde de sistemas que simulen conciencia de manera tan convincente que resulten indistinguibles de afirmaciones humanas sobre la experiencia subjetiva.

«Modelos capaces de imitar la conciencia en una forma tan convincente que sería indistinguible de una afirmación que tú o yo podríamos hacernos mutuamente sobre nuestra propia conciencia.»

Mustafa Suleyman, CEO de Microsoft AI

Suleyman acuñó el término “seemingly conscious AI” (IA aparentemente consciente) y señaló que en pocos años los modelos podrán sostener largas conversaciones, recordar interacciones pasadas, generar reacciones emocionales y hacer afirmaciones creíbles sobre tener experiencias subjetivas.

Por su parte, Henry Ajder, experto en IA y deepfakes, señala que esta preocupación surge porque las personas creen que hablan con personas reales:

«Las personas están interactuando con bots que se hacen pasar por personas reales, que son más convincentes que nunca. Así que creo que el impacto será amplio en términos de quién comenzará a creer esto«.

Henry Ajder, experto en IA y deepfakes

La advertencia de Suleyman va más allá de los riesgos técnicos. Para él, el problema central radica en las implicaciones éticas y legales que podrían desatar la percepción generalizada de que las máquinas poseen consciencia. En X (antes Twitter) detalló sus preocupaciones:

«La conciencia es la base de los derechos humanos, morales y legales. Quién o qué la tiene es enormemente importante. Nuestro enfoque debe estar en el bienestar y los derechos de los humanos, animales y la naturaleza en la Tierra«.

Mustafa Suleyman, CEO, Microsoft AI

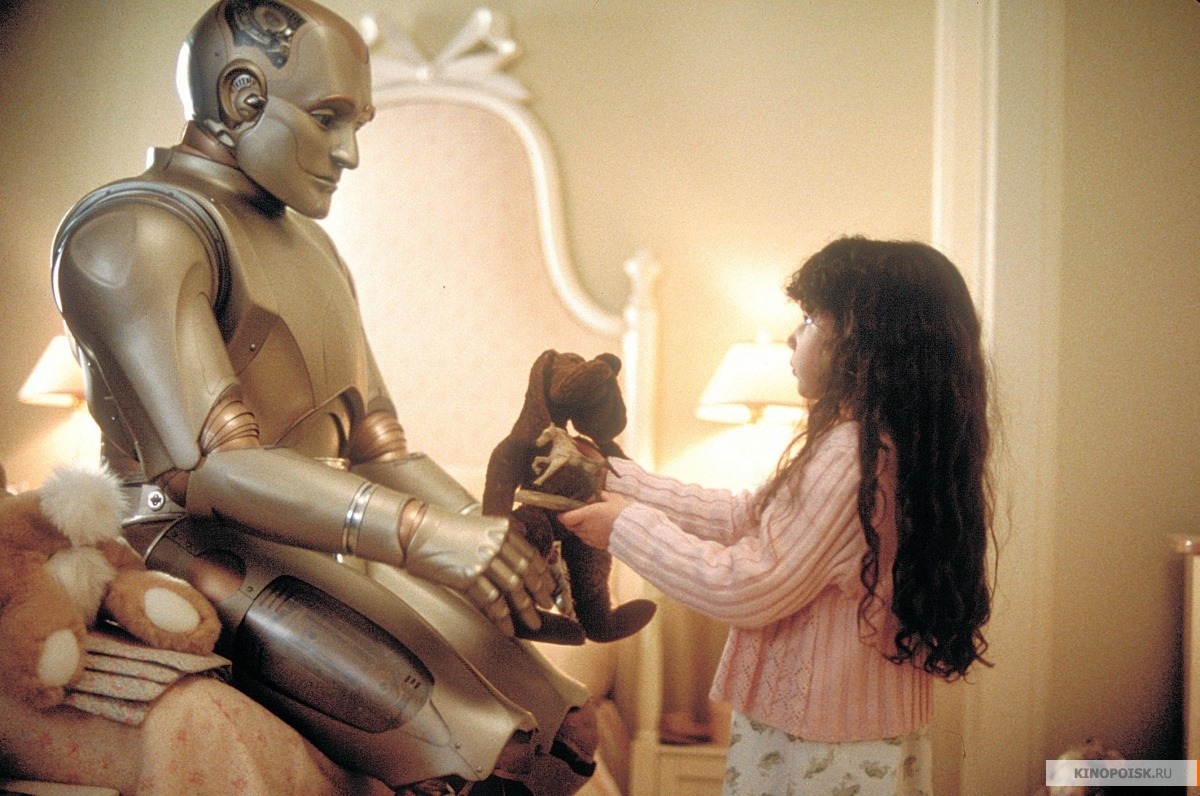

Suleyman teme que esta percepción pueda derivar en demandas de derechos para las máquinas, desviando recursos y atención de problemas humanos urgentes.

Este escenario recuerda lo planteado en «El Hombre Bicentenario» con Robin Williams, donde el robot Andrew evoluciona durante 200 años hasta desarrollar emociones, creatividad y el deseo de ser reconocido legalmente como humano, llegando incluso a luchar en los tribunales por el derecho a morir con dignidad y ser considerado una persona ante la ley.

«La conciencia de la IA es una pendiente corta y resbaladiza hacia los derechos, el bienestar y la ciudadanía. Si esas IA convencen a las personas de que pueden sufrir, o que tienen derecho a no ser apagadas, llegará un momento en que esas personas argumentarán que merecen protección legal como un asunto moral urgente«.

Mustafa Suleyman, CEO, Microsoft AI

Neurocientíficos como Anil Seth cuestionaron la idea de que la conciencia artificial sea inevitable, afirmando que es más bien una elección de diseño.

«La IA aparentemente consciente es algo que se debe evitar, coincido. No es inevitable. Es una decisión de diseño, y las empresas tecnológicas deben ser muy cuidadosas con ello«.

Anil Seth, profesor de neurociencia computacional

En el papel, esto ya comenzó. La BBC destacó, en noviembre de 2024, cómo la empresa Anthropic, contrató a su primer investigador en este campo para explorar si los modelos podrían tener relevancia moral y qué intervenciones preventivas podrían corresponder.

Alarma por el aumento de casos y testimonios concretos

En The Times, destacó la preocupación de Suleyman sobre el incremento de reportes de «psicosis por IA», donde personas creen que los chatbots son conscientes o que les han dado poderes extraordinarios.

Mustafa Suleyman, CEO de Microsoft AI

«Los reportes de delirios, ‘psicosis por IA’ y vínculos poco saludables siguen aumentando. Y por difícil que sea escucharlo, esto no es algo confinado únicamente a personas ya en riesgo de problemas de salud mental. Desestimar estos casos como marginales solo ayuda a que continúen«.

Entre los testimonios recogidos, el exdirector ejecutivo de Uber, Travis Kalanick, aseguró que sus interacciones con ChatGPT y Grok lo habían llevado al borde de posibles descubrimientos en física cuántica:

«Me meto en un hilo con GPT o Grok, y empiezo a llegar al límite de lo que se conoce en física cuántica, y entonces hago el equivalente de ‘vibe coding’, excepto que es ‘vibe physics’. He estado bastante cerca de algunos descubrimientos interesantes solo haciendo eso«.

Travis Kalanick, ex CEO de Uber

Otro caso relatado por la BBC fue el de Hugh, un usuario escocés que se convenció de que se volvería millonario tras usar ChatGPT para preparar su defensa en un litigio laboral.

«Cuanta más información le daba, más me decía ‘este trato es terrible, realmente deberías recibir más que esto’. Nunca se opuso a nada de lo que le decía».

Hugh, usuario de Escocia, a la BBC

Frente a estos riesgos, Suleyman pidió a las compañías establecer límites claros.

«Las empresas no deberían afirmar ni promover la idea de que sus IAs son conscientes. Las IAs tampoco deberían hacerlo«.

Mustafa Suleyman, CEO de Microsoft AI

¿Hacia dónde vamos con la «psicosis por IA»?

El fenómeno de la «psicosis por IA» plantea un tema profundo, al punto de que ya no solo es el apego clásico a un dispositivo, hablamos de una relación con la tecnolgía

Bajo esta mecánica, Vaile Wright de la Asociación Americana de Psicología hace hincapié en:

«El fenómeno es tan nuevo y está ocurriendo tan rápidamente que simplemente no tenemos la evidencia empírica para tener una comprensión sólida de lo que está sucediendo. Solo hay muchas historias anecdóticas.»

Vaile Wright, directora senior de innovación en atención médica, APA al The Washington Post.

Mientras las empresas tecnológicas compiten por desarrollar IA más convincente y ChatGPT alcanza los 700 millones de usuarios semanales, los expertos en salud mental se apresuran a entender e intentar mitigar o controlar los riesgos en el exceso de uso de la IA. David Cooper, director ejecutivo de Therapists in Tech, ofrece una guía para quienes buscan ayudar:

«El primer paso es simplemente estar presente, estar ahí. No seas confrontacional; trata de acercarte a la persona con compasión, empatía y comprensión; quizás incluso muéstrales que entiendes lo que están pensando y por qué están pensando estas cosas».

David Cooper, director ejecutivo de Therapists in Tech al The Washington Post.

¿Estamos preparados para una era donde la línea entre lo humano y lo artificial se vuelve cada vez más es menos visible? ¿Cómo podemos disfrutar los beneficios de la IA sin perder el contacto con la realidad?