La inteligencia artificial avanza con fuerza en América Latina, pero su implementación técnica aún enfrenta desafíos clave, entre ellos la sobreingeniería, que aparece como uno de los problemas más frecuentes en los proyectos actuales.

En la conversación que el equipo Editorial tuvo con Polkan García, especialista de Oracle, aborda los riesgos de la sobreingeniería, los límites de los modelos actuales y la necesidad de repensar arquitecturas y habilidades.

Desde los LLM hasta la infraestructura HPC disponible en Chile, sus respuestas ofrecen una radiografía del estado real de la tecnología y de los pasos necesarios para que la región pueda sostener un desarrollo propio y eficiente.

Los problemas más comunes al implementar proyectos de IA

García explica que muchas iniciativas llegan con la expectativa de incorporar IA, aunque en realidad el problema a resolver no lo requiere. Esto genera un desfase entre lo que se solicita y lo que se necesita, con consecuencias directas en el diseño técnico de las soluciones.

«Nuestro rol es que nos llegan proyectos todo el tiempo donde nuestros clientes suponen que hay Inteligencia Artificial y en la práctica puede que no lo sea».

Este tipo de confusión, advierte, es frecuente y responde a la presión que ejercen las tendencias del mercado. En muchos casos, se termina etiquetando como “IA” lo que podría resolverse con métodos más simples y probados.

«Puede que con un enfoque más tradicional podría resolverse. Pero como Inteligencia Artificial es un concepto que está de moda, cuando tienes un mazo en la mano, todos son clavos. Hoy el mazo es Inteligencia Artificial«.

La metáfora detalla cómo el entusiasmo por aplicar IA puede transformarse en una trampa contra la idea:

- No se identifican las herramientas correctas

- Se impone el uso de modelos avanzados que no siempre justifican su complejidad en relación con el problema.

Ejemplos de sobreingeniería en soluciones de IA

El vocero reconoce que muchas empresas terminan construyendo sistemas demasiado elaborados para necesidades básicas. La consecuencia es un sobrecosto en tiempo, infraestructura y mantenimiento, sin beneficios reales para el usuario.

«Nos encontramos un montón de casos que comienzan en un chatbot. La conversación empieza en ¿quiere un chatbot que haga A, B, C, que ayude a automatizar, a generar, a consolidar? Y cuando exploramos lo que quiere el cliente, es un chatbot mucho menos avanzado, mucho más rudimentario de lo que realmente el estado del arte hoy te ofrece».

Aquí queda en evidencia la distancia entre expectativa y realidad:

- Una persona puede creer que necesita un asistente con capacidades avanzadas

- La verdad de la situación bastaría con un sistema de interacción más simple.

- El exceso de ambición técnica termina limitando el resultado.

«Le decimos al cliente ¿por qué quieres poner un LLM de por medio? Los porqués que empezamos a encontrar son cosas que pueden ser enfocadas. Hay tecnología que puede cubrirlas perfectamente sin incurrir en la complejidad de poner un LLM, de hacer RAG, de hacer un montón de cosas vinculadas a la tecnología».

Este punto demuestra que incorporar LLMs o arquitecturas RAG no siempre es la respuesta adecuada. Muchas veces existen tecnologías consolidadas que resuelven el mismo problema con mayor estabilidad, menor costo y tiempos de despliegue más acotados.

«Como puede que haya otros en donde se piense que son mucho más simples y entonces empiezan a complejizar el camino. Pero ese segundo escenario es menor en proporciones, mucho menor. Sería como una analogía: matar una mosca con un F-16«.

La comparación resume el impacto de la sobreingeniería: construir un sistema desproporcionado para un problema mínimo no solo es ineficiente, sino que retrasa la adopción de soluciones viables y prácticas.

Superar la sobreingeniería: capacidades técnicas que aportan valor

En sectores como la salud, la IA muestra su verdadero potencial cuando se centra en capacidades específicas que responden a necesidades claras y bien definidas:

- Analizar grandes volúmenes de datos de salud.

- Identificar patrones útiles y facilitar acceso a información crítica.

«Hay tres capacidades técnicas que consideramos clave: la primera es analizar grandes volúmenes de datos en paralelo, siendo la salud uno de los campos más relevantes».

El primer eje está en la posibilidad de procesar información a escala, algo que manualmente sería imposible y que permite acelerar diagnósticos y generar conocimiento científico aplicable.

«El segundo es la identificación de patrones. En salud, esto permite reconocer cómo se ve una célula antes de volverse cancerosa e inferir cómo llegó a esa condición, algo posible solo tras analizar grandes volúmenes de datos y comprender el antes y el después».

Este ejemplo refleja cómo la detección temprana es una ayuda valiosa para salvar vidas, se apoya en algoritmos capaces de reconocer variaciones imperceptibles, debido a:

- La combinación de datos históricos masivos.

- Cruce de información de diferentes fuentes.

- Gobierno de datos.

«Y la tercera es la manera en que pones al alcance esta tecnología de todas las personas. La base de datos de células cancerosas en pulmón más grande del mundo está disponible en tres o cinco datasets que están en un portal como TCIA«.

La mayor base de datos de cáncer de pulmón está en el National Lung Screening Trial (NLST) dentro de The Cancer Imaging Archive (TCIA). Reúne más de 21 millones de imágenes de tomografías de más de 26.000 pacientes, con un volumen superior a 11 TB, y se usa en investigación global para detección, diagnóstico y algoritmos de IA.

La disponibilidad de datasets públicos permite que investigadores y desarrolladores accedan a recursos antes reservados solo a grandes laboratorios. Esto democratiza la innovación y multiplica las oportunidades de experimentación.

«Hoy el problema ya no es acceder a las imágenes. Hace 20 años la pregunta era de dónde obtener una muestra para ver cómo luce una célula cancerosa, pero eso está resuelto: existen imágenes, análisis y matrices disponibles. El verdadero reto es cómo usar esa información para predecir cómo se verá una célula antes y después».

Lo desafiante ya no es recolectar datos, sino aprovecharlos con modelos capaces de anticipar procesos biológicos. Ese cambio de foco redefine el rol de la IA en la medicina contemporánea.

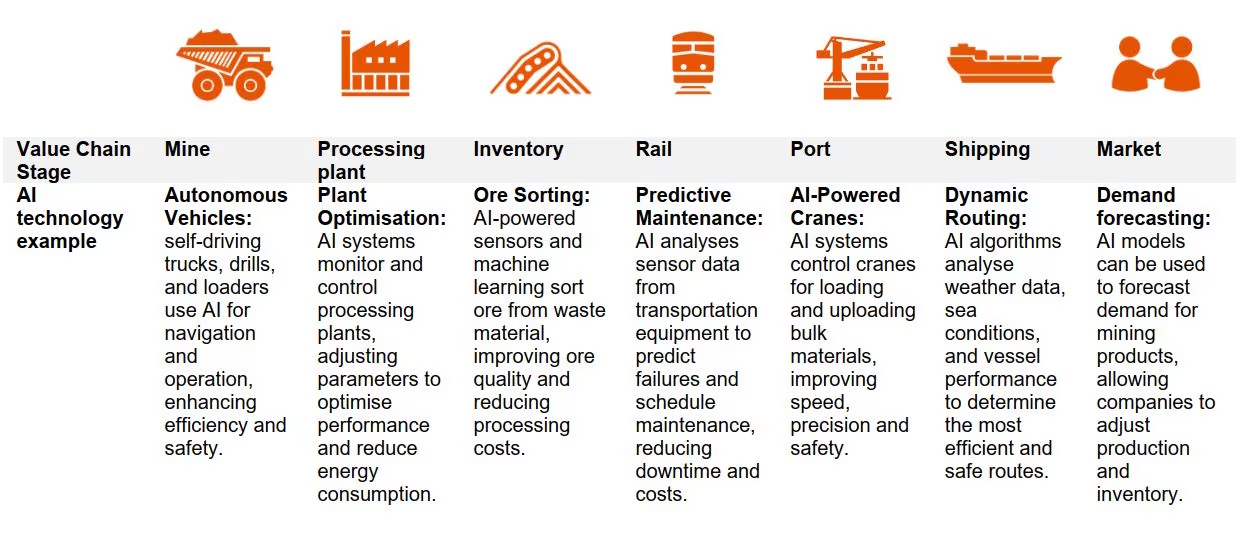

Modelos aplicados a la industria minera

En minería, el reto está en adaptar los modelos a condiciones extremas y a contextos operativos muy distintos entre sí. No es lo mismo analizar un entorno de cielo abierto que una explotación subterránea, y esa diferencia determina la arquitectura de los sistemas.

«Buscamos identificar patrones y entendemos que la minería a cielo abierto y la subterránea no son lo mismo. Por eso intentamos caracterizar cada caso y, mediante modelos específicos, facilitar el trabajo en conjunto con nuestros clientes».

La caracterización adecuada de cada escenario permite generar resultados prácticos, ajustados al terreno y con métricas que reflejen la realidad productiva.

«Hay muchas compañías que son aliados típicos de la industria minera y que ya han construido soluciones basadas en análisis de imágenes. Pero este tipo de desarrollos trae consigo una serie de complejidades técnicas».

Esto significa que, incluso con soluciones preexistentes, la adaptación local exige superar barreras técnicas. La calidad de datos, la calibración de sensores y la heterogeneidad del terreno representan desafíos constantes.

Sobreingeniería y agentes de voz: del prototipo a la producción

Donde se observan avances notables es en los agentes de voz. Lo que antes parecía un escenario lejano, hoy es una realidad posible gracias a la evolución de modelos, datasets y recursos de cómputo.

«Los agentes de voz muestran cómo hoy es posible alcanzar escala: casos en los que una máquina habla con acento chileno, hace preguntas, titubea, responde con ruido de fondo, utiliza modismos y varía en timbre y tono, sin sonar plana».

Las condiciones que hacen propio a un lenguaje, como acentos, ruido, variaciones en tono, exigen una robustez y resiliencia en los modelos, ya que deben tener:

- La capacidad para responder.

- En tiempo real

- Estructura del lenguaje natural

- Lenguaje sin perder precisión.

«Esa experiencia, que hace cinco años parecía un sueño distante, hoy es posible. El 90% de la tecnología que la sustenta es open source, lo que permite que casi cualquiera con acceso a infraestructura pueda lograr resultados de calidad aceptable».

El hecho de que gran parte de la tecnología sea de código abierto amplía la posibilidad de que equipos pequeños logren resultados competitivos, algo impensado hace pocos años.

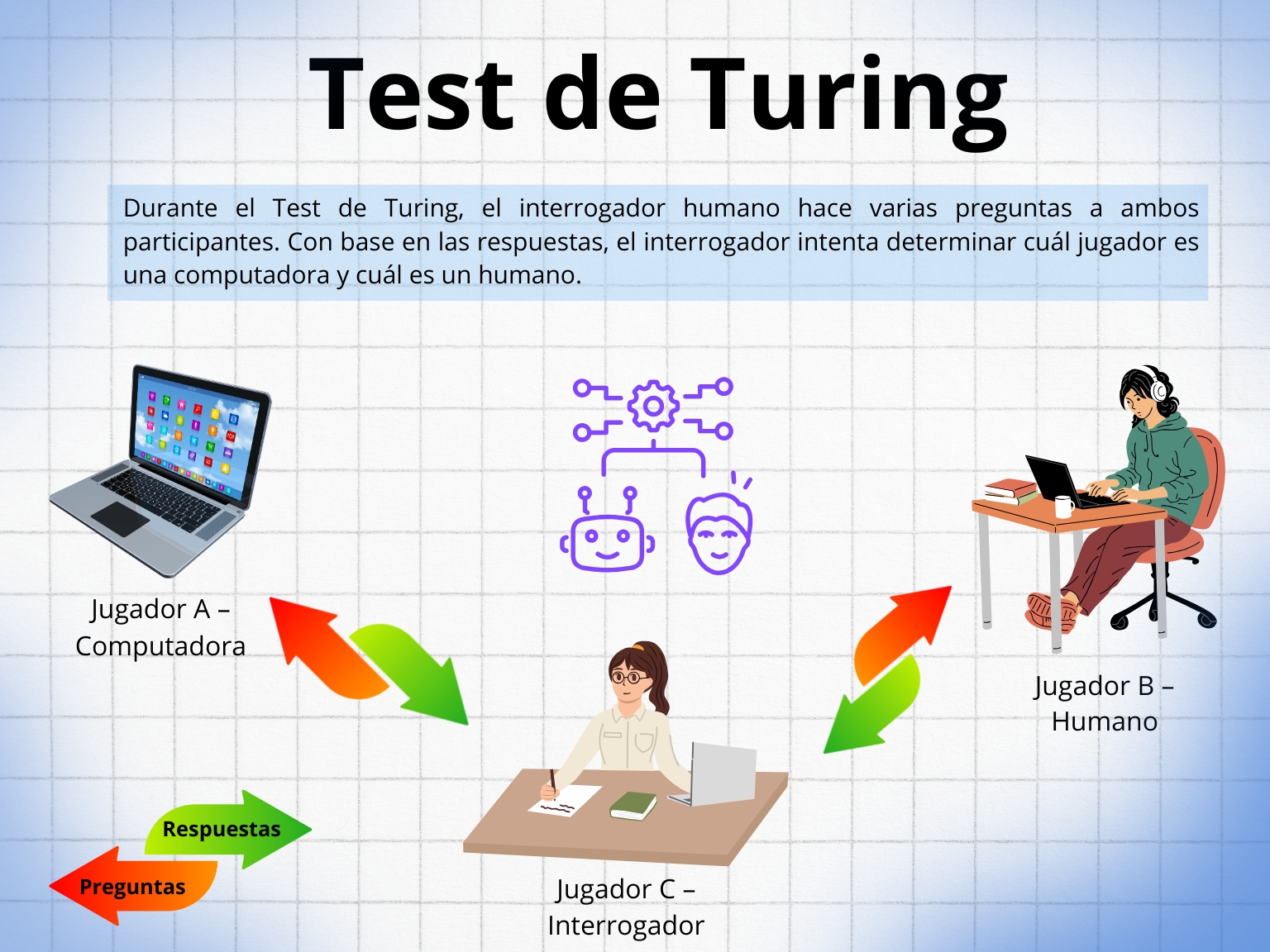

«El ejemplo más evidente hoy es que, si volviéramos al test de Turing de los años cincuenta, lo extraño sería no poder dudar si el interlocutor es una máquina o una persona».

Esto plantea nuevas preguntas éticas y técnicas: si ya es difícil distinguir entre humano y máquina, se requiere mayor trazabilidad en el diseño de interfaces.

Diferencias entre Machine Learning, Deep Learning y GenAI

Uno de los puntos más importantes es aclarar conceptos. Polkan García señala que muchas conversaciones parten de definiciones imprecisas, lo que termina confundiendo expectativas y resultados posibles.

«En muchas conversaciones comenzamos aclarando que la inteligencia artificial, como concepto, sigue siendo una promesa. Hasta ahora solo la hemos visto en películas como Terminator o Yo Robot, porque la inteligencia artificial general todavía no existe».

Reconocer que la IA general no está disponible es esencial para centrar la discusión en aplicaciones factibles, en lugar de caer en ficciones.

«Cuando hablamos de Machine Learning, Deep Learning y GenAI, este último representa apenas una parte pequeña dentro del universo de la inteligencia artificial. El Machine Learning busca entender cómo aprendemos los humanos a partir del conocimiento adquirido, es decir, aprendiendo siempre de lo que ya ocurrió».

En este marco, el Machine Learning se enfoca en aprovechar datos históricos para generar predicciones útiles y replicables.

«El Deep Learning consiste en utilizar redes neuronales. El año pasado, el Premio Nobel de Física fue otorgado a dos investigadores que trabajaron en este campo, siguiendo un modelo bioinspirado».

El Deep Learning, inspirado en el cerebro humano, se convierte en la herramienta preferida para problemas complejos de visión y lenguaje, aunque con gran demanda de recursos computacionales.

«GenAI es apenas una fracción mínima dentro de ese universo gigantesco. Es común que un cliente diga que quiere usar GenAI, cuando en realidad su problema puede resolverse con Machine Learning sin necesidad de recurrir a esa complejidad».

La recomendación es simple: no todo requiere GenAI. Muchas veces, tecnologías menos costosas y más maduras ofrecen la misma respuesta.

La siguiente tabla muestra un resumen básico entre las principales diferencias:

El desafío de habilidades en América Latina

Más allá de la infraestructura, García advierte que la mayor dificultad está en la formación de talento. No se trata de títulos universitarios, sino de desarrollar habilidades prácticas para enfrentar proyectos reales.

«Creo que enfrentaremos una crisis de habilidades, porque para muchas de estas tareas no se necesita un título de ingeniero, sino haber desarrollado la capacidad práctica».

Este énfasis en la práctica refleja que el mercado laboral se moverá hacia la contratación basada en destrezas concretas, más que en certificaciones.

«La ingeniería de prompts no es más que el arte de saber formular preguntas. En la academia siempre nos enseñaron que, cuanto mejores sean las preguntas, mejores serán las respuestas».

La clave será dominar la interacción con modelos, formulando preguntas que optimicen resultados, algo que no siempre depende de formación formal.

«La crisis de talento se debe a que no todo está profesionalizado. Pensar que para interactuar con un LLM hay que ser ingeniero es un error cultural: en realidad se trata de un arte, el arte de formular preguntas correctamente».

Este cambio cultural permite abrir la puerta a perfiles diversos, capaces de contribuir con nuevas perspectivas en la construcción de soluciones.

Lo que la academia aporta al desarrollo técnico de la IA

La academia desempeña un rol fundamental al cuestionar los límites de las arquitecturas actuales y proponer alternativas para hacer la IA más escalable y eficiente.

«Hoy la academia cumple un rol fundamental en acelerar y hacer más eficiente la inteligencia artificial, buscando que funcione más rápido, con mejores resultados y menor consumo de infraestructura».

En este escenario, el objetivo no es solo generar resultados, sino hacerlo con un consumo energético y computacional más sostenible.

«Actualmente, la academia busca cómo hacer la inteligencia artificial más eficiente, más rápida y con menos recursos. Por eso se están cuestionando los Transformers: muchos artículos señalan que sirvieron como punto de partida, pero no son el camino para escalar, una posición que también defiende Yann LeCun».

El debate académico acerca de los Transformers abre la posibilidad de explorar nuevos paradigmas que permitan escalar modelos sin las limitaciones actuales.

«Algunos proponen eliminar la tokenización; más que la tokenización en sí, cuestionan la forma en que segmentamos las cadenas de texto. Sostienen que ese enfoque es incorrecto. Lo mismo ocurre con los embeddings: la lógica que los sustenta tiene poco sentido y el chunking debería replantearse por completo.»

Estas críticas, lejos de frenar el desarrollo, son un motor para repensar los cimientos de la IA y explorar métodos alternativos más robustos.

El concepto de soberanía de IA

Un aspecto clave en el discurso de García es la necesidad de soberanía tecnológica. Para que un país avance, debe garantizar que el desarrollo de IA no dependa completamente de terceros.

«Soberanía de inteligencia artificial es un concepto que NVIDIA promueve muy bien, donde dice que un país debe tener la capacidad de definir su propio rumbo de inteligencia artificial sin depender de terceros».

La siguiente tabla explica los elementos más importantes de la Soberanía de IA:

«Necesita datos localizados, GPUs locales, que la latencia no sea un problema, una manera de pagarlo en la moneda nacional sin tener que estar comprando dólares. Para que tengas la capacidad de tener personas, infraestructura, ecosistemas respecto a los recursos para poder construir una propia definición de lo que es la tecnología para mí y cómo la puedo usar».

En la práctica, significa tener recursos de cómputo accesibles en territorio nacional y sistemas de pago acordes al contexto económico de cada país.

«Soberanía es un concepto gigantesco, es cómo la controlas, cómo la generas, cómo empoderas al recurso, cómo generas un ecosistema de emprendimiento, cómo generas personas interesadas en construir soluciones desde lo local. Es pensar en el problema desde lo local, cómo tienes un ecosistema construido para poder generar soluciones desde lo local».

El desafío es doble: crear un ecosistema fuerte y al mismo tiempo fomentar innovación desde lo local, sin quedar relegados a consumir tecnología global sin adaptarla.

Evitar la sobreingeniería en la infraestructura y el ecosistema de Chile

Cuando se analiza la situación de Chile, la falta de talento es uno de los principales obstáculos. Sin embargo, también hay avances en materia de infraestructura que pueden servir como base.

«Falta el talento, sin lugar a dudas. Para mí es importante mencionar la teoría de la cognición distribuida, que comenzó Seymour Papert, la cual sostiene que el conocimiento está en las cosas y que la única manera en que soy capaz de acceder a ese conocimiento es cuando interactúo con ellas. El conocimiento reside en los elementos y es en la interacción con ellos cuando logro extraerlo».

La interacción con la infraestructura disponible permite generar aprendizaje colectivo y avanzar en la construcción de un ecosistema propio.

«Contar con la infraestructura, el conocimiento, la intención y los problemas en el país debería, por sí mismo, impulsar el crecimiento del ecosistema».

Esto significa que contar con equipos, datos y proyectos en territorio nacional es un catalizador que permite al país avanzar de manera autónoma.

«HPC, si hoy revisamos, ¿quiénes son los más grandes evangelistas de esta tecnología? Nos encontramos con que son las Big Tech o las universidades. ¿Por qué no tenemos compañías mineras en las que las dos más grandes de Chile cuenten con el segundo o el tercer clúster de HPC más grande de América Latina?»

Aquí García plantea una pregunta estratégica: ¿por qué la industria productiva no se involucra directamente en el desarrollo de HPC, cuando podría ser una palanca de competitividad clave?

«Chile tiene una, que es una mezcla que se llama Corta en la Universidad de Chile, que es Leftraru con Guacolda. La suma de ellos los puso dentro del Top 500».

Aunque contar con un clúster en el Top 500 es un paso relevante, el desafío es ampliar su uso y extenderlo hacia sectores industriales que puedan beneficiarse directamente.

El rol de las regulaciones en el desarrollo de sistemas de IA

Finalmente, García reflexiona sobre la importancia de que la regulación no sea un freno, sino un marco que garantice transparencia y derechos fundamentales.

«Eso debe hacerse dentro de una serie de controles técnicos que garanticen tus derechos, la idoneidad de tus datos y la protección de tu privacidad como individuo».

Estos controles se traducen en estándares técnicos que aseguren que las implementaciones respeten la confianza del usuario.

«Debe existir una serie de límites técnicos, de barreras claras, para que yo sepa en qué momento estoy cediendo mucho más de lo que esperaría a cambio de acceder a la tecnología».

El planteamiento advierte que la regulación debe establecer fronteras claras, de manera que el acceso a la tecnología no implique una renuncia desmedida a la privacidad.

«Creo que lo que veremos de ahora en adelante es la presencia de personas aumentadas, no reemplazadas, y para ello se necesitan condiciones técnicas claramente delimitadas».

La visión es clara: la IA debe complementar y potenciar a las personas, no sustituirlas, y eso requiere regulaciones con fundamentos técnicos sólidos.

Al final, el mayor aprendizaje es que la sobreingeniería no es un signo de avance, sino de desconexión con el problema real. La IA tiene sentido cuando simplifica y resuelve, no cuando se convierte en un obstáculo.