Desde hace algún tiempo que venimos tocando tangencialmente el tema de Data Centers en el sitio. Sin embargo, desde nuestra visita al laboratorio Nacional de Supercómputo (NLHPC) en la Facultad de Ingeniería en la Universidad de Chile, ha cambiado nuestra visión, y esperamos con el tiempo, ampliar nuestra cobertura en este tema, de ahí nuestra intención de conocer cómo la industria local tomó el anuncio del El Plan Nacional de Data Centers (PDATA).

Pablo García, voz autorizada de Cirion Technologies

Con más de 20 años en el rubro de data centers y ciberseguridad, Pablo García de Cirion Technologies, firma infraestructura de Centros de Datos a nivel regional, ha sido testigo de cómo ha crecido el sector en Latinoamérica.

Actualmente, el ejecutivo de Cirion, lidera la estrategia regional de Data Centers en Cirion Technologies, abarcando mercados clave como México, Colombia, Ecuador, Venezuela, Argentina, Perú y Chile.

En el ámbito profesional, cuenta con una destacada trayectoria, ocupando roles estratégicos en firmas como CenturyLink, Level 3 Communications e Impsat Fiber Networks, que le permiten ser voz autorizada en materia de infraestructura digital y servicios críticos.

En esta entrevista, profundizamos lo que significa el Plan Nacional de Data Centers de Chile (PDATA), analizando las políticas que el Estado de Chile ha sugerido, junto con sus implicancias para la industria, el papel de la inversión privada. Asimismo, las oportunidades y los nuevos escenarios que se desarrollarán por la demanda de cómputos.

Si buscas profundizar más sobre el PDATA, puedes visitar la página del Ministerio de Ciencias de Chile.

Entrevista a Pablo García en el marco del Plan Nacional de Data Centers de Chile (PDATA)

¿Qué tecnologías específicas se están utilizando en Chile para identificar las zonas óptimas de instalación de data centers, según el Plan Nacional?

PDATA se basa en una combinación de tecnologías geoespaciales, análisis de datos y criterios ambientales para identificar las zonas óptimas para la instalación de data centers. Entre las tecnologías más utilizadas están:

- Sistemas de información geográfica (SIG): Para mapear las características geográficas, climáticas y geológicas de diferentes regiones.

- Big Data y Análisis Predictivo: Utilizados para predecir la demanda de servicios y optimizar la localización de los data centers.

- Modelos de simulación de energía: Para evaluar la disponibilidad de fuentes de energía renovables y no renovables en diversas áreas.

- Tecnologías de monitoreo ambiental: Para identificar factores de riesgo como inundaciones, incendios forestales y sismos.

Una de las medidas que busca el Estado de Chile con el Plan, es que las nuevas infraestructuras se proyecten de manera sustentable, para ello dentro de las medidas del PDATA donde el Estado será garante de acuerdos por producción de energías limpias. ¿Cómo impacta la disponibilidad energética y la conectividad en el diseño técnico de los nuevos data centers del plan?

La disponibilidad energética y la conectividad son factores críticos en el diseño de los Data Centers en Chile, dado que estas instalaciones requieren una energía estable y confiable. El Plan enfatiza la transición hacia fuentes de energía renovable (solar, eólica y geotérmica), para reducir la huella de carbono de las instalaciones, y los data centers híbridos, que combinan energía convencional y renovable, son una tendencia creciente. Además, se evalúa la capacidad de la red eléctrica local para asegurar que no haya cortes de suministro o problemas de sobrecarga.

El país está invirtiendo en mejorar la infraestructura de conectividad a través de fibra óptica y redes 5G, y en proyectos de interconexión a nivel mundial. Las zonas seleccionadas para los data centers se priorizan por su acceso a centros de distribución de Internet y a cables submarinos internacionales.

¿Qué estándares se están implementando en términos de eficiencia energética para cumplir con los criterios de sostenibilidad del plan?

El Plan Nacional está alineado con los estándares internacionales de eficiencia energética, como:

- PUE (Power Usage Effectiveness): Indicador utilizado para medir la eficiencia energética de los data centers. Un PUE bajo indica que el centro utiliza eficientemente su energía.

- WUE (Water Usage Effectiveness): Es una métrica que se utiliza para cuantificar la eficiencia con la que un centro de datos utiliza el agua. Compara la cantidad de agua utilizada, para enfriar los equipos de TI y controlar la humedad, con la cantidad de energía utilizada para alimentar los equipos de TI.

- LEED (Leadership in Energy and Environmental Design): Certificación ambiental que el Plan está impulsando para asegurar que los nuevos data centers sigan las mejores prácticas en construcción sostenible.

- Normativas de la ISO 50001: Gestión de la energía para asegurar el uso eficiente de los recursos y la mejora continua.

¿Conoce algún proyecto de energías renovables que esté pensado específicamente para alimentar data centers? ¿Cuáles?

Chile ha sido pionero en la implementación de energías renovables en su infraestructura tecnológica. Algunos proyectos relevantes incluyen:

Parques solares en el norte: Se están construyendo grandes parques solares fotovoltaicos en el desierto de Atacama, con el objetivo de abastecer a los data centers cercanos con energía limpia.

Existen también algunos proyectos que se han instalado en la Región Metropolitana (Colina) que permiten mayor cercanía con los grandes centros de datos.

Proyectos eólicos: En la región de la Patagonia, se están desarrollando proyectos de energía eólica que también pueden ser aprovechados por las instalaciones de data centers.

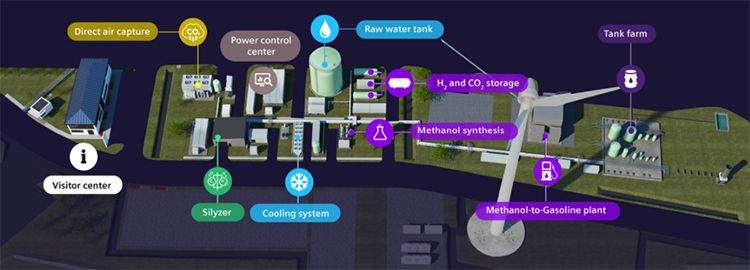

Hidrógeno verde: Chile está explorando el uso de hidrógeno verde como fuente de energía renovable a largo plazo, con la posibilidad de utilizarlo para alimentar data centers de manera sostenible. Para esto, recordemos el proyecto piloto «Haru Oni» de H2V de Enel, ubicado en Cabo Negro, al norte de Punta Arenas, en la Región de Magallanes.

Data Centers antisísmicos

Si recuerdan el 2010, el core de la conectividad nacional se mantuvo en pie, los data centers siguieron funcionando sin que se vieran afectados los servicios. Es un claro antecedente de que, en esta materia sísmica, Chile es reconocido a nivel global. Sin embargo, es de extrañar, que en los documentos expuestos en el Ministerio de Ciencias, no se mencionen directamente los sismos como parte de las medidas.

En términos de infraestructura física, ¿cómo se asegura la resiliencia de los data centers ante desastres naturales comunes en Chile?

Chile es un país con una alta actividad sísmica, por lo que la resiliencia ante desastres naturales es clave. El diseño de los data centers considera estructuras sísmicas reforzadas con materiales y técnicas de construcción capaces de soportar terremotos de alta magnitud, cumpliendo con las normativas NCh433 de 1996, modificada en 2012, (Norma de Diseño Sísmico de Chile). Al mismo tiempo, se utilizan tecnologías que reducen el efecto de los sismos sobre la estructura (aisladores sísmicos).

Nótese: El equipo editorial piensa que es correcto considerar la norma NCh2369 de Diseño sísmico de estructuras e instalaciones industriales, puesto que un DC contiene infraestructura crítica.

También se aborda la redundancia, a través de la implementación de sistemas de alimentación eléctrica y refrigeración redundantes para asegurar que los servicios no se vean interrumpidos en caso de fallos en alguno de los sistemas, así como ubicación estratégica en zonas fuera de las áreas de riesgo sísmico o de otros desastres naturales, como inundaciones.

¿Qué características deben cumplir los data centers en países sísmicos como es Chile? ¿En el Plan Nacional (PDATA), hay algo que refleje este punto?

En países sísmicos como Chile, los data centers deben ser capaces de soportar movimientos sísmicos de alta magnitud, contar con sistemas de anclaje y refuerzo estructural que minimicen los daños durante un terremoto e incluir sistemas de generadores de respaldo y baterías de alta capacidad para evitar interrupciones en caso de corte de energía.

El Plan Nacional refleja estos requisitos con la incorporación de estándares de manera implícita, cuando se habla de resiliencia ante afectos climáticos, asegurando que cada nueva instalación esté diseñada para soportar eventos sísmicos extremos.

En una entrevista que DataCenterDynamics (DCD) con, Mauro Leuce, jefe global de diseño e ingeniería de Colt Data Center Services, el ejecutivo señaló que la manera de cómo se trabaja en Japón es con base en aislación a nivel basal, usando aisladores sísmicos (probablemente con núcleos de plomo).

“Desde una perspectiva de costos, probablemente sea más fácil aislar la estructura para que flote sobre la tierra mientras todo lo demás se mueve, en lugar de lo que generalmente se hace en edificios comerciales o residenciales, donde se intenta restringir los sistemas, como tuberías, cables eléctricos, transformadores, generadores, cualquier otra cosa”.

Mauro Leuce de Colt DC

La capacidad de cómputo según Plan Nacional de Data Center (PDATA)

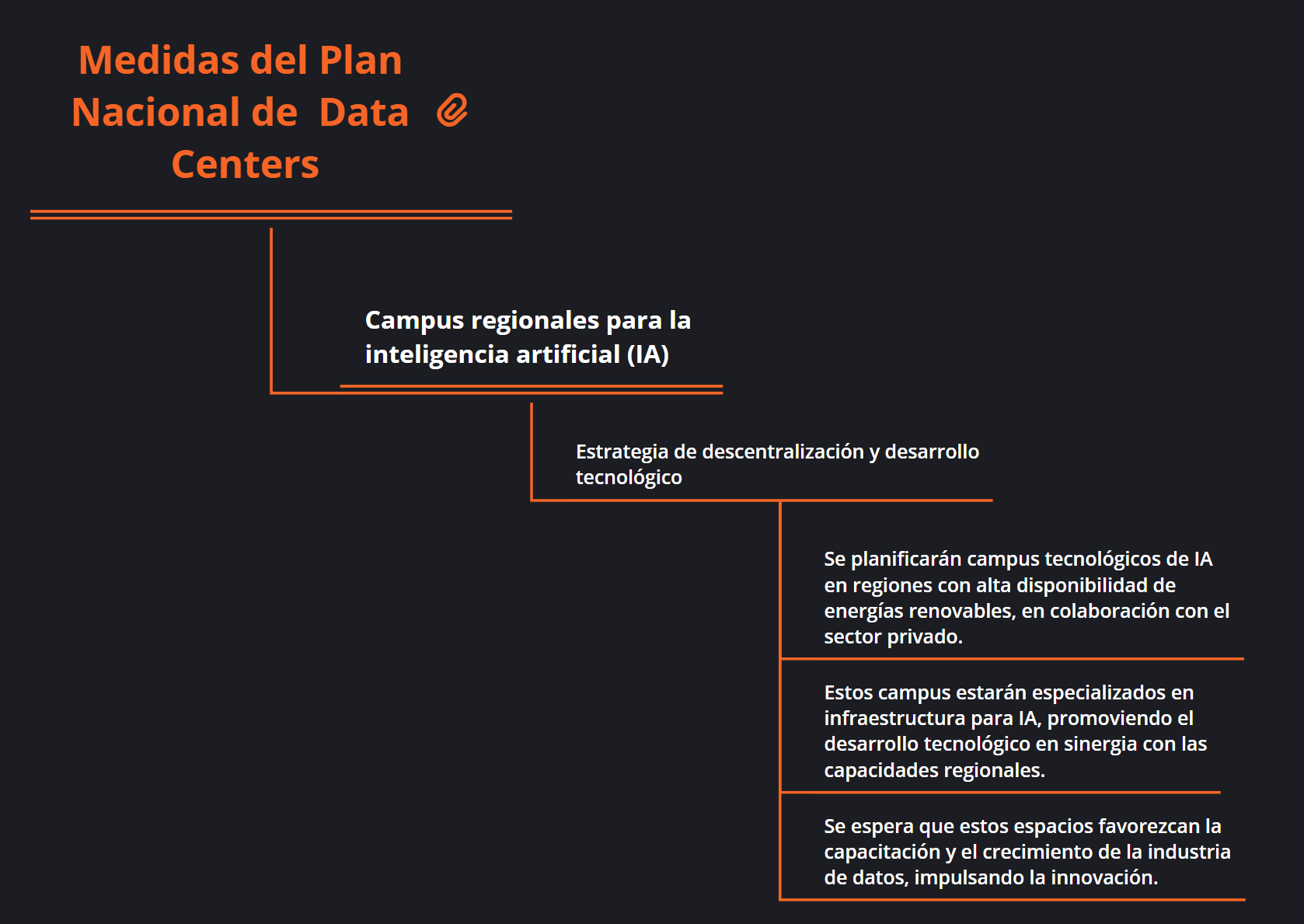

Entre las medidas que plantea PDATA para cumplir con sus tres objetivos fundamentales, está el número 7 que corresponde a la instalación de un Campus de IA. Recordemos que las tarjetas gráficas (GPU), son las unidades por excelencia para el rendimiento en Inteligencias Artificial.

Ahora, si miniaturizamos un DC a nivel de PCs de escritorios, sabemos que la mayor cantidad de TOPS las entregan las tarjetas gráficas, gracias a los múltiples núcleos que trabajan en paralelo, como referencia:

- La serie Intel Lunar Lake incluye una cuarta generación de una NPU que arroja unos 48TOPS

- Una GPU integrada de Intel llega a los 67TOPS

- GPU NVIDIA 3090 llega a los 285TOPS

- GPU NVIDIA 4090 alcanza 1321TOPS

- GPU NVIDIA 5090 la mejor actualmente, llega a 3352TOPS

Es decir, de manera implícita, PDATA establece una medida que afecta, directa e indirectamente, al condicionar el Campus de IA.

Mario Velázquez, expresidente Clúster Sur Andino en Schneider Electric, quien falleció a fines de 2024, compartió un punto clave en cuanto a consumo energético de los centros de procesamiento de datos. Destaca que los DC tradicionales son mucho más predecibles en su consumo, ya que están destinados a cargas estándares; en cambio, los de DC para IA requieren una mayor capacidad de cómputo y, en consecuencia, consumo eléctrico:

[…] Los data centers tradicionales tienen un consumo eléctrico más predecible, ya que están optimizados para cargas de trabajo estándar. Diferente al caso de los data centers que trabajan con IA, ya que requieren una mayor potencia de cómputo y, por lo tanto, pueden tener un consumo eléctrico significativamente mayor; Estamos hablando que una demanda de energía que es exponencial en estos casos. (Ej. Un rack convencional consume en promedio de 3kW a 5kW, un rack de IA consume 20kW a 120kW).

Mario Velázquez, en una entrevista para Tabulado.

¿Cómo aborda el Plan Nacional la capacidad de cómputo necesaria para proyectos de investigación y desarrollo (I+D) en Chile?

El Plan Nacional considera la capacidad de cómputo como un pilar para el desarrollo de I+D en el país. Se están promoviendo infraestructuras de alta capacidad que incluyen supercomputadoras para investigación científica y tecnológica avanzada, redes de alto rendimiento (HPC) que aporten conectividad rápida y segura para manejar grandes volúmenes de datos y análisis complejos y clusters de datos para investigación en áreas como astronomía, biotecnología y minería.

Sistemas de refrigeración y la evaluación ambiental para nuevos centros de procesamiento según PDATA

El sistema de refrigeración que siempre se ha usado en Centros de Datos son los por aire acondicionados, si bien hoy en día son mucho más eficientes, gracias a su tecnología inverter, se siguen explorando alterativas de refrigeración, como la líquida. En este ámbito, Vertiv es una de las empresas que está trabajando en diferentes sistemas, como el trabajo conjunto que está realizando con Intel, ya que Gaudi3 estará capacitado para enfriarse por líquido o por aire.

¿Cómo se integra la refrigeración avanzada y el uso de energías renovables en los proyectos de data centers promovidos por el gobierno?

La refrigeración avanzada se está convirtiendo en un componente clave en el diseño de los data centers. Se están promoviendo soluciones como refrigeración líquida como alternativa a la tradicional refrigeración por aire, lo que mejora la eficiencia energética y permite operar a mayores densidades de servidores; el uso de energías renovables para alimentar sistemas de refrigeración, especialmente en zonas donde la energía solar y eólica son abundantes, y tecnologías de refrigeración geotérmica en ciertas áreas del país, aprovechando la energía térmica del subsuelo.

Más detalles cómo están trabajando en esta solución, puedes ver el siguiente video de Vertiv.

¿Seguiremos usando sistemas convencionales de refrigeración basados en aires acondicionados o avanzaremos a refrigeración líquida?

El futuro se está orientado hacia la refrigeración líquida debido a su mayor eficiencia energética y capacidad de manejar altas densidades de servidores. La refrigeración por inmersión (sumergir componentes en líquidos refrigerantes) es una de las tecnologías emergentes que podría ganar relevancia en los próximos años.

Con la creciente demanda de datos y el compromiso con la sostenibilidad, es probable que en Chile veamos una transición hacia tecnologías de refrigeración líquida, especialmente en data centers de alta densidad, como los que podrían surgir bajo el PDATA. Algunos factores que podrían acelerar esta adopción son:

- Iniciativas de sostenibilidad público-privadas.

- Colaboración con líderes tecnológicos que ya implementan estas soluciones.

- Incentivos regulatorios para promover tecnologías más eficientes y amigables con el medio ambiente.

Aunque los sistemas convencionales seguirán teniendo un lugar en algunas instalaciones, la refrigeración líquida es la tecnología del futuro en los data centers modernos. Esta transición no solo responde a la necesidad de eficiencia y sostenibilidad, sino también a la creciente demanda de capacidades de procesamiento en la era de la digitalización.

Los desafíos que arroja la evaluación ambiental

El Plan Nacional de Data Centers (PDATA), busca implementar medidas para garantizar un desarrollo sostenible en la industria del procesamiento de datos. Con ello establece criterios de evaluación ambiental y la promoción de acuerdos de producción limpia, fomentando eficiencia energética e hídrica y mejores prácticas en el país.

El plan menciona la creación de criterios técnicos para la evaluación ambiental. ¿Qué desafíos enfrenta esta integración técnica en la práctica?

Uno de los principales desafíos es la armonización de las normativas ambientales con los requerimientos técnicos de los data centers. La implementación de criterios de sostenibilidad a menudo puede entrar en conflicto con la necesidad de alta eficiencia y la demanda de recursos para operar. Además, la integración de energías renovables en áreas remotas y la gestión de los residuos electrónicos de los data centers son desafíos técnicos adicionales.

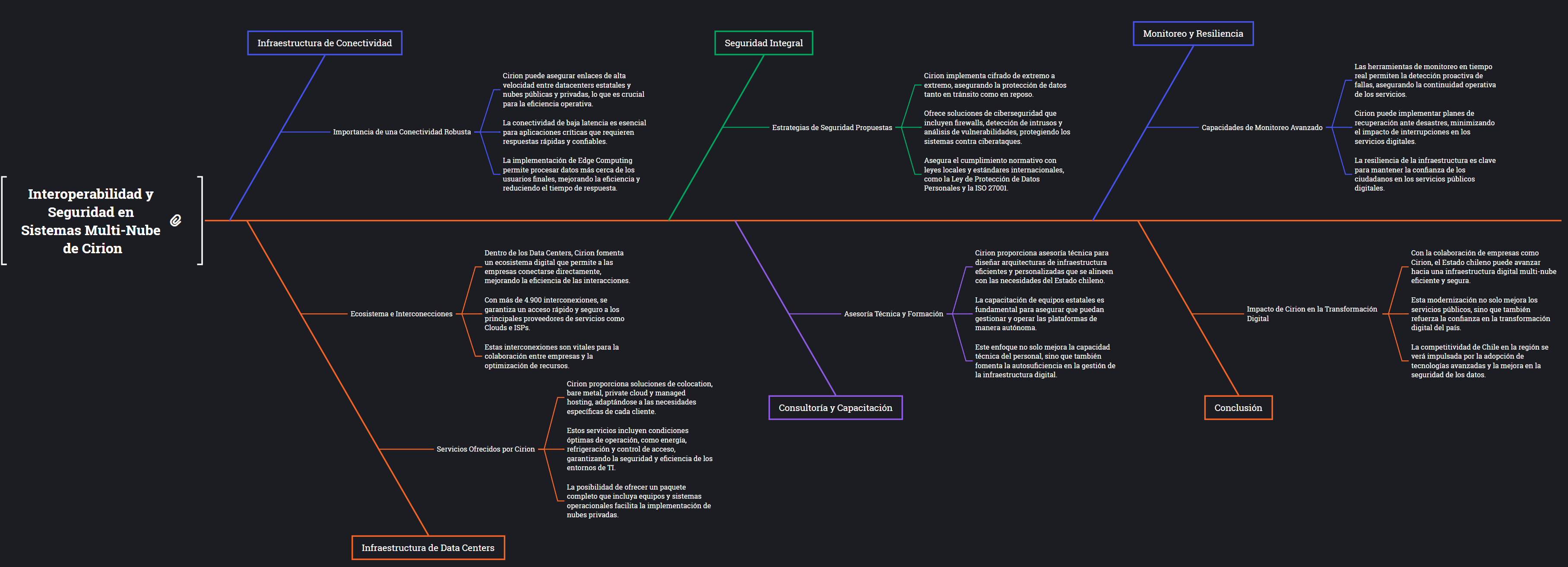

Interoperabilidad y la seguridad de estos sistemas desde el punto de vista de Cirion

El plan menciona el impulso al servicio de multi-nube estatal. Desde el punto de vista técnico, ¿cómo se asegura la interoperabilidad y la seguridad de estos sistemas?

El PDATA en Chile busca modernizar los servicios digitales a través de un sistema multi-nube estatal, una estrategia que utiliza distintas plataformas de nube para optimizar servicios públicos. Sin embargo, esto plantea desafíos técnicos clave que deben abordarse para garantizar la interoperabilidad y la seguridad.

Para que los sistemas de diferentes proveedores de nube trabajen juntos, se requiere:

- Estándares comunes: Usar herramientas y protocolos que permitan a las plataformas comunicarse entre sí, como APIs abiertas y contenedores como Docker o Kubernetes.

- Gestión centralizada: Monitorear y configurar servicios desde una sola plataforma.

En un entorno multi-nube, la protección de datos es esencial:

- Cifrado de datos: Proteger la información en tránsito y almacenada.

- Control de accesos: Asegurar que solo usuarios autorizados accedan a los sistemas, con soluciones modernas como modelos de «confianza cero».

- Monitoreo constante: Detectar y responder rápidamente a posibles amenazas.

Finalmente, es clave establecer políticas claras que alineen las prácticas en todas las plataformas y aseguren el cumplimiento de normativas como la Ley de Protección de Datos Personales en Chile.

Con una combinación de tecnologías interoperables, políticas de seguridad robustas y un marco de gobernanza centralizado, el servicio multi-nube estatal puede operar de forma eficiente y segura, impulsando el desarrollo digital del país.

Cirion ya tiene parte del camino recorrido

¿Cómo firmas como Cirion podrían facilitar la interoperabilidad y la seguridad de estos sistemas según las medidas que establece el PDATA?

Empresas como Cirion Technologies, con experiencia en infraestructura digital y servicios en la nube, pueden desempeñar un papel fundamental para que el proyecto de multi-nube estatal en Chile sea un éxito. Su aporte puede enfocarse en varios aspectos clave, como:

Infraestructura de Conectividad, Cirion, como proveedor de infraestructura tecnológica, puede garantizar una conectividad robusta y de baja latencia entre los datacenters estatales y las plataformas de nube pública y privada. Esto incluye:

- Redes de alta velocidad: Enlaces seguros y confiables entre diferentes nubes.

- Edge Computing: Procesamiento de datos cerca de los usuarios finales para mejorar la eficiencia.

Infraestructura de Data Centers. Cirion ofrece estructuras de Data Center que garantizan las condiciones ideales de operación para los ambientes de TI de empresas y gobiernos:

- Colocation, Bare Metal, Private Cloud y Managed Hosting: Espacios para abrigar equipos, garantizando energía, refrigeración, control de acceso y todas las condiciones definidas por los criterios de certificación de estos ambientes. Estos servicios están disponibles desde abrigar equipos del cliente mismo, hasta ofrecer todo el paquete con equipos, sistemas operacionales y mismo el armado de nubes privadas.

- Ecosistema e Interconexiones: Dentro del Data Center, además de usufructuar de las condiciones adecuadas para el procesamiento de sus datos, el cliente encuentra todo un ecosistema digital con otras empresas con quien puede conectarse directamente ahí mismo. Estas interconexiones garantizan enlaces más eficientes y seguros para los negocios. Hoy tenemos más de 4.900 interconexiones entre diferentes empresas y entre empresas y los principales proveedores de servicios como Clouds y ISPs (Internet Service Providers).

Seguridad Integral. Con un enfoque en seguridad, Cirion puede proporcionar:

- Cifrado de extremo a extremo: Protección avanzada de datos en tránsito y en reposo.

- Soluciones de ciberseguridad: Herramientas para prevenir y mitigar ciberataques, como firewalls, detección de intrusos y análisis de vulnerabilidades.

- Cumplimiento normativo: Asegurar que las operaciones cumplan con leyes locales, como la Ley de Protección de Datos Personales, y estándares internacionales como ISO 27001.

Consultoría y Capacitación. Cirion también puede aportar experiencia en diseño e implementación:

- Asesoría técnica: Diseñar arquitecturas de infraestructura eficientes y personalizadas para el Estado chileno.

- Capacitación: Transferir conocimiento técnico a los equipos estatales para que puedan gestionar y operar las plataformas de manera autónoma.

Monitoreo y Resiliencia. Las capacidades de monitoreo avanzado de Cirion permitirían:

- Detección proactiva de fallas: Asegurar la continuidad operativa con herramientas de monitoreo en tiempo real.

- Planes de recuperación ante desastres: Implementar estrategias para minimizar el impacto de interrupciones.

Con empresas como Cirion facilitando infraestructura, tecnología y seguridad, el Estado chileno puede lograr una transición eficiente hacia una infraestructura digital multi-nube Esto no solo moderniza los servicios públicos, sino que también refuerza la confianza en la transformación digital del país, impulsando su competitividad en la región.

Tecnologías emergentes consideradas en el PDATA

¿Qué tecnologías emergentes, como el edge computing o la inteligencia artificial, están consideradas en el plan para mejorar la eficiencia y escalabilidad?

Las tecnologías emergentes, como el Edge Computing y la Inteligencia Artificial (IA), están desempeñando un papel crucial en la mejora de la eficiencia y escalabilidad de los Data Centers modernos.

El Edge Computing implica mover el procesamiento de datos desde un Data Center centralizado hacia los dispositivos o «nodos» cercanos a la fuente de datos. Este enfoque reduce la latencia y mejora la velocidad de respuesta para aplicaciones críticas que requieren tiempos de respuesta casi instantáneos, como vehículos autónomos, IoT (Internet de las Cosas), y aplicaciones de video en tiempo real.

En términos de escalabilidad, el Edge Computing permite que las empresas implementen recursos de forma distribuida, lo que facilita el escalado horizontal en lugar de depender exclusivamente de un centro de datos centralizado.

A nivel de eficiencia, al procesar datos localmente y solo enviar información relevante al centro de datos principal, se reduce la carga de tráfico en la red, optimizando los recursos y disminuyendo el consumo de ancho de banda.

La IA por su parte, es utilizada para gestionar la infraestructura del Data Center de manera más eficiente. Por ejemplo, la IA puede predecir fallos en el hardware antes de que ocurran, optimizar la distribución de recursos, gestionar la energía de manera más efectiva y mejorar las estrategias de refrigeración.

Los algoritmos de IA también pueden optimizar las operaciones de los Data Centers analizando grandes volúmenes de datos en tiempo real y ajustando automáticamente el uso de recursos según las necesidades cambiantes.

En términos de escalabilidad, la IA permite a los Data Centers adaptarse a una demanda creciente sin la necesidad de intervención manual constante, haciendo que los sistemas sean más autónomos y resilientes.

Hardware dedicado para tareas específicas en los centros de procesamiento de información

¿Está Cirion trabajando en hardware especializado?

En Cirion constantemente estamos explorando la adopción de hardware especializado para mejorar el rendimiento y la eficiencia. Este tipo de hardware incluye procesadores diseñados para cargas de trabajo específicas, como FPGAs (Field-Programmable Gate Arrays) y ASICs (Application-Specific Integrated Circuits), que son más eficientes para tareas de alta demanda computacional.

Nos estamos enfocando en optimizar el rendimiento de los centros de datos y mejorar la eficiencia energética, por lo que este tipo de hardware podría incluir:

Procesadores para AI y Machine Learning: A medida que la demanda de procesamiento para aplicaciones de IA crece, los Data Centers necesitan adaptarse con hardware más potente y eficiente, como los TPUs (Tensor Processing Units) de Google o las tarjetas gráficas especializadas en cómputo paralelo (GPUs).

Hardware optimizado para Edge Computing: El aumento de la conectividad y la mayor cantidad de datos que generan las cosas y las personas están impulsando a las organizaciones a buscar nuevas maneras de procesar y almacenar datos donde se adquieren, analizan y actúan sobre ellos. Edge computing satisface esa necesidad al colocar las cargas de trabajo más cerca de las interacciones digitales, lo que permite a las organizaciones mejorar las experiencias de sus clientes.

El PDATA y los requisitos de clase mundial

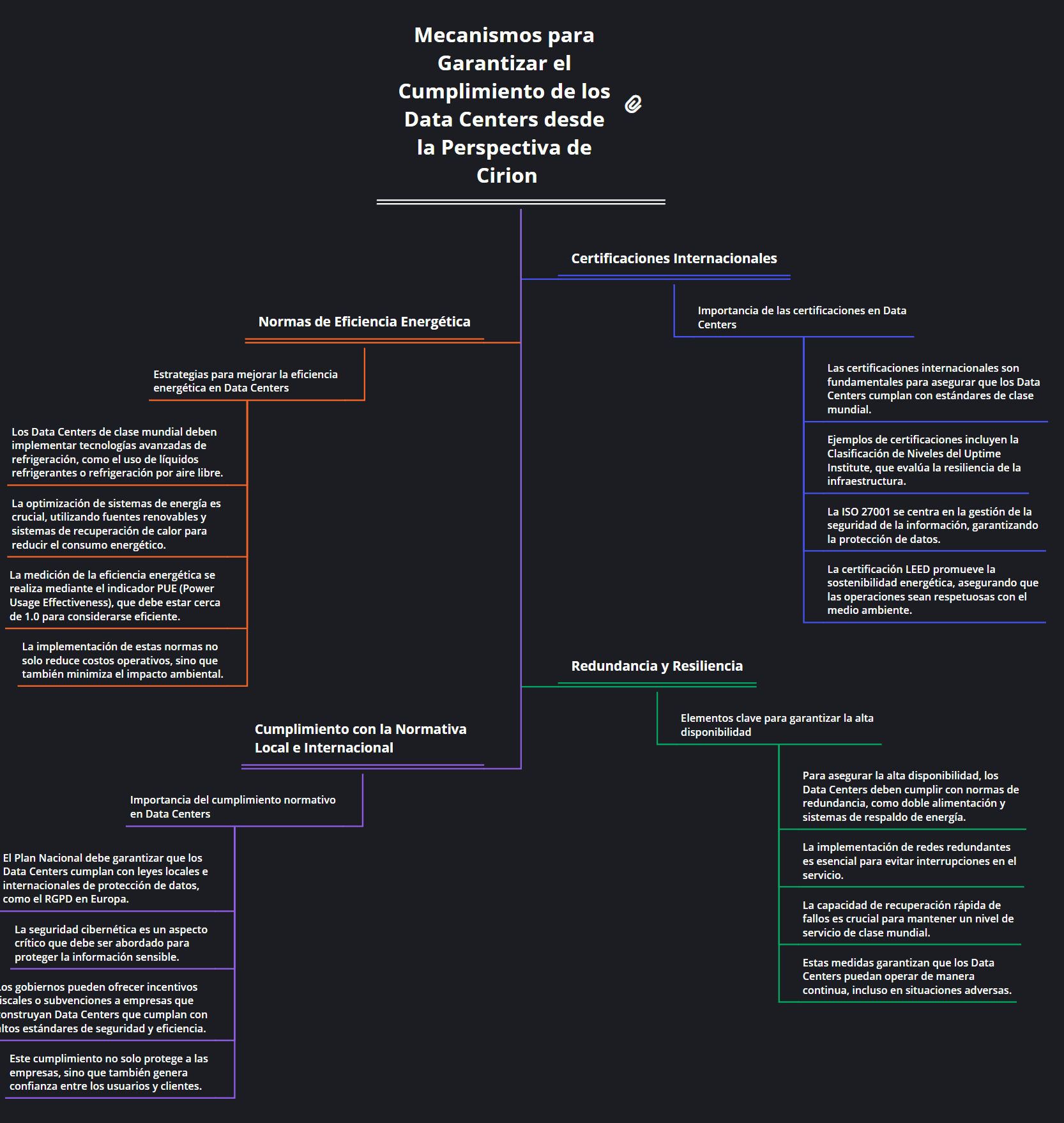

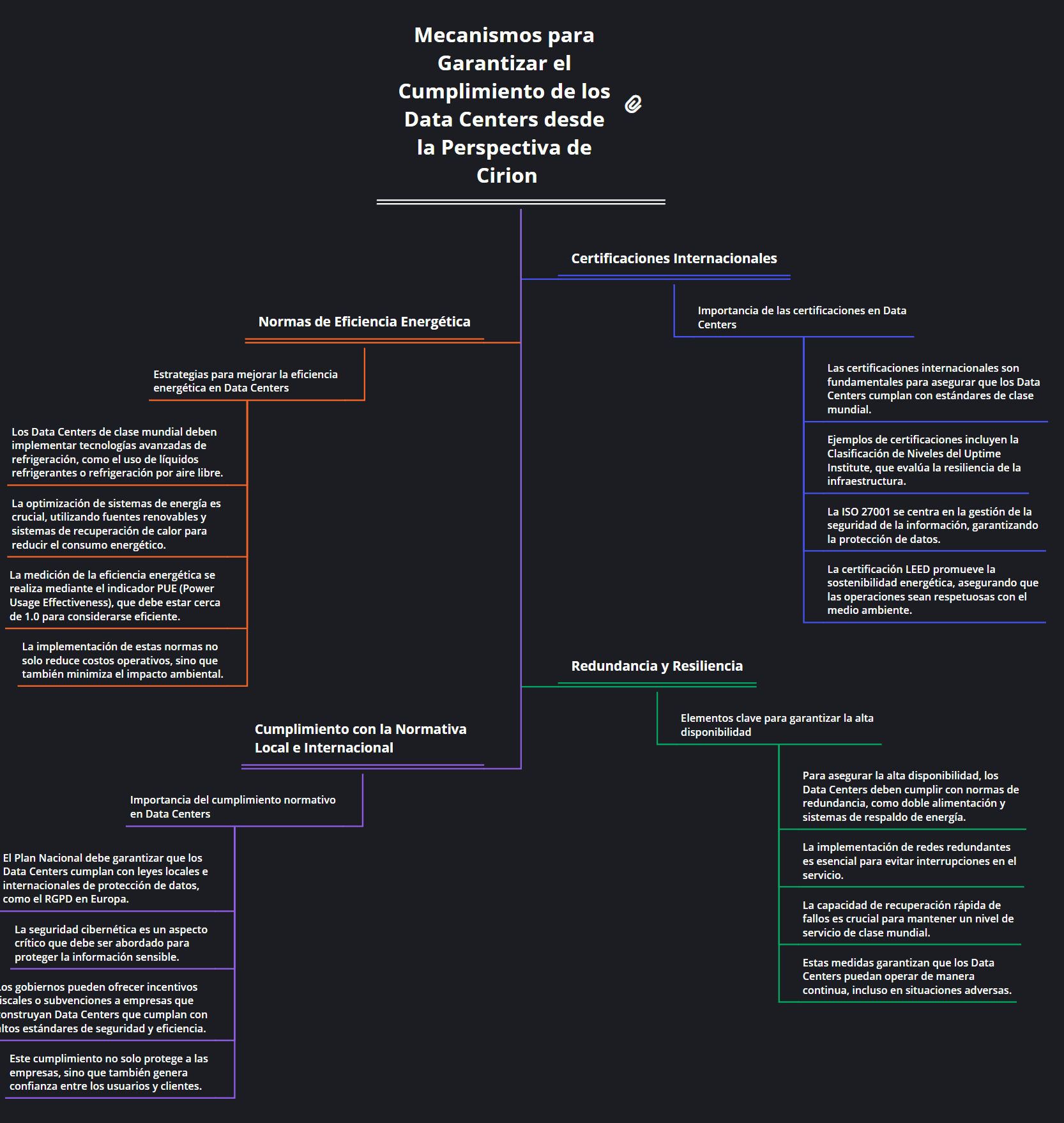

¿Cómo garantiza el Plan Nacional que los Data Centers cumplan con los requisitos de clase mundial?

Los requisitos de clase mundial para los Data Centers se refieren a altos estándares de fiabilidad, seguridad, eficiencia energética y escalabilidad. El Plan Nacional (PDATA) de desarrollo de infraestructura para Data Centers (PDATA) debería estar alineado con los estándares internacionales y aprovechar las mejores prácticas de la industria.

Desde una perspectiva técnica, existen varios mecanismos que pueden garantizar que los Centros de Datos cumplan con estos requisitos:

Certificaciones internacionales: Para cumplir con los estándares de clase mundial, el Plan Nacional probablemente promoverá la adopción de certificaciones internacionales como Uptime Institute’s Tier Classification, ISO 27001 para gestión de seguridad de la información, o LEED para sostenibilidad energética. Estas certificaciones aseguran que los Data Centers cumplan con los requisitos de resiliencia, seguridad, y eficiencia.

Normas de eficiencia energética: Los Data Centers de clase mundial requieren un bajo consumo de energía y alta eficiencia operativa. Para esto se deben implementar tecnologías de refrigeración avanzadas como el uso de líquidos refrigerantes o refrigeración por aire libre, y se deben optimizar los sistemas de energía, utilizando fuentes renovables y sistemas de recuperación de calor. Además, la medición de la eficiencia energética se realiza mediante el indicador PUE (Power Usage Effectiveness), el cual debe estar cerca de 1.0 para ser considerado eficiente.

Redundancia y resiliencia: Para garantizar que un Data Center tenga alta disponibilidad, debe cumplir con normas de redundancia (por ejemplo, doble alimentación, sistemas de respaldo de energía, redes redundantes). Además, deben ser capaces de recuperarse rápidamente de fallos, lo cual es clave para mantener un nivel de servicio de clase mundial.

Cumplimiento con la normativa local e internacional: Dependiendo de la región, el Plan Nacional también debe garantizar que los Data Centers cumplan con leyes locales e internacionales de protección de datos (como el RGPD en Europa) y seguridad cibernética. Además, los gobiernos pueden apoyar con incentivos fiscales o subvenciones para empresas que construyan Data Centers con estos altos estándares.

¿Qué te pareció la entrevista? ¿Cuéntanos si hay otros temas que te gustaría que tratáramos?