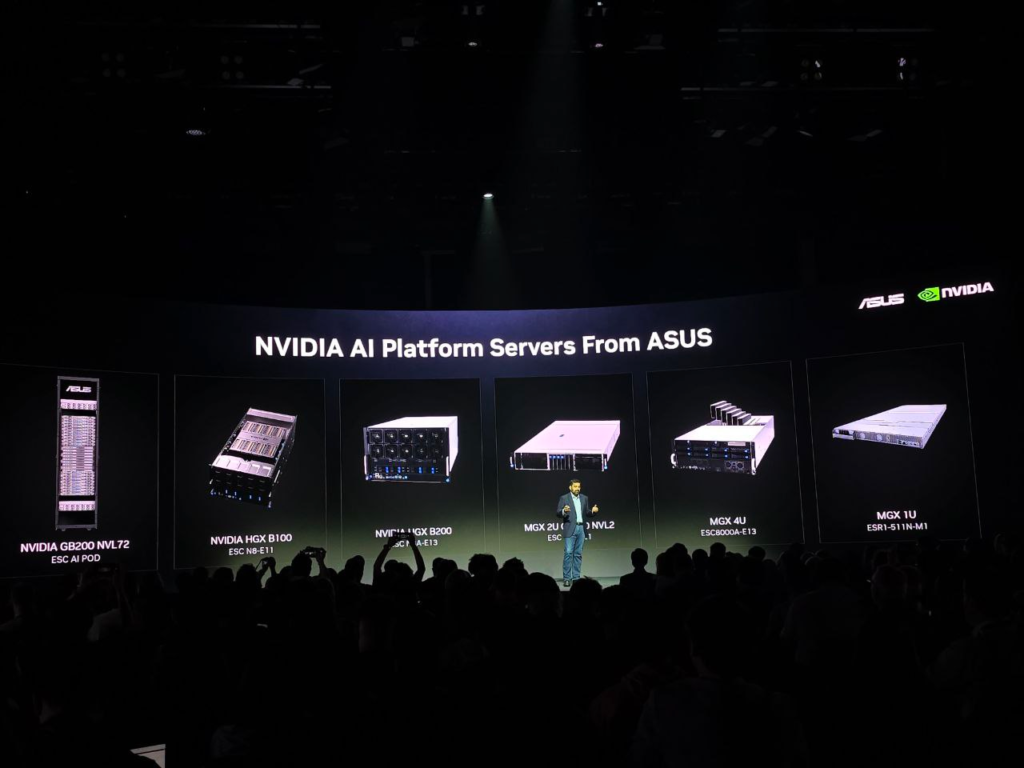

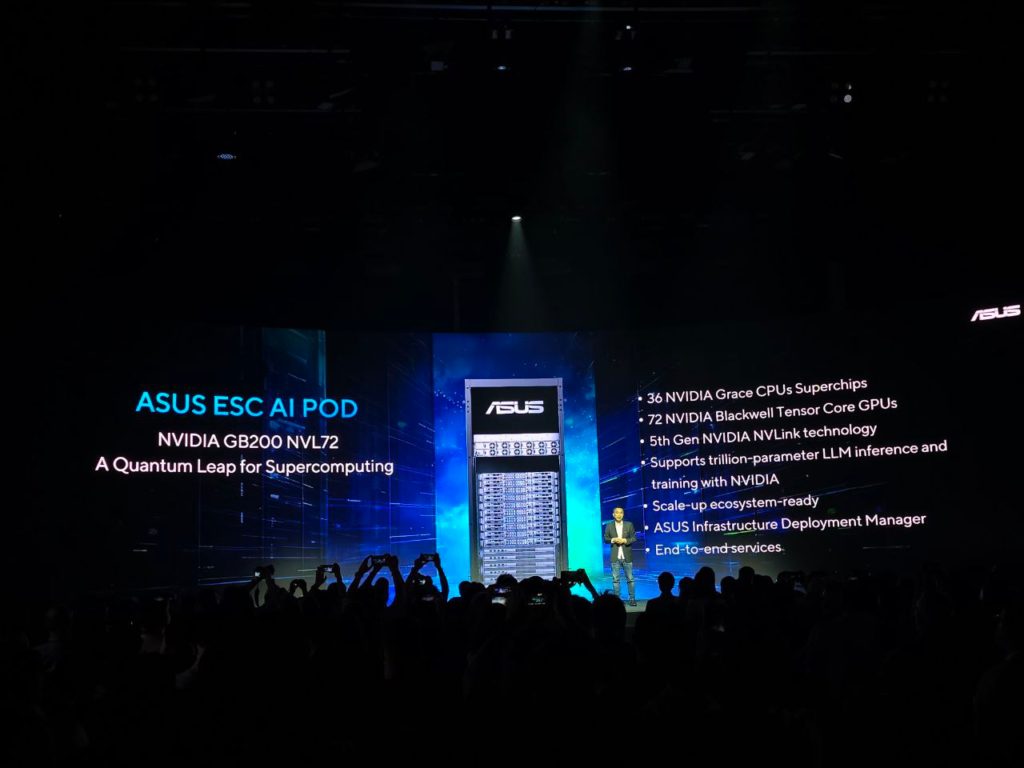

En el marco de la feria más grande de computación global, ASUS ya ha dado luces de grandes anuncios en LAPTOS. En servidores dedicados a IA, tampoco se quedaron atrás, anunciaron el ASUS ESC AI POD alimentado con la potencia de la plataforma NVIDIA GB200 NVL72.

El fabricante taiwanés destaca que su solución ASUS ESC AI POD es una respuesta al explosivo aumento de requisitos de hardware para poder mover los lenguajes de gran tamaño (LLM) como ChatGPT. También señala que su experiencia en conjunto con el sistema de NVIDIA, forman una solución completa en rack para los billones de parámetros que requiere la GenAI, así lo destacó el VP y codirector de Asus en Open Platafform BG:

“Nuestra asociación con NVIDIA, líder mundial en informática de inteligencia artificial, respalda nuestra experiencia. Juntos, hemos aprovechado una potente sinergia que nos permite crear servidores de IA con un rendimiento y eficiencia incomparables”

Paul Ju, vicepresidente corporativo de ASUS y codirector de Open Platform BG.

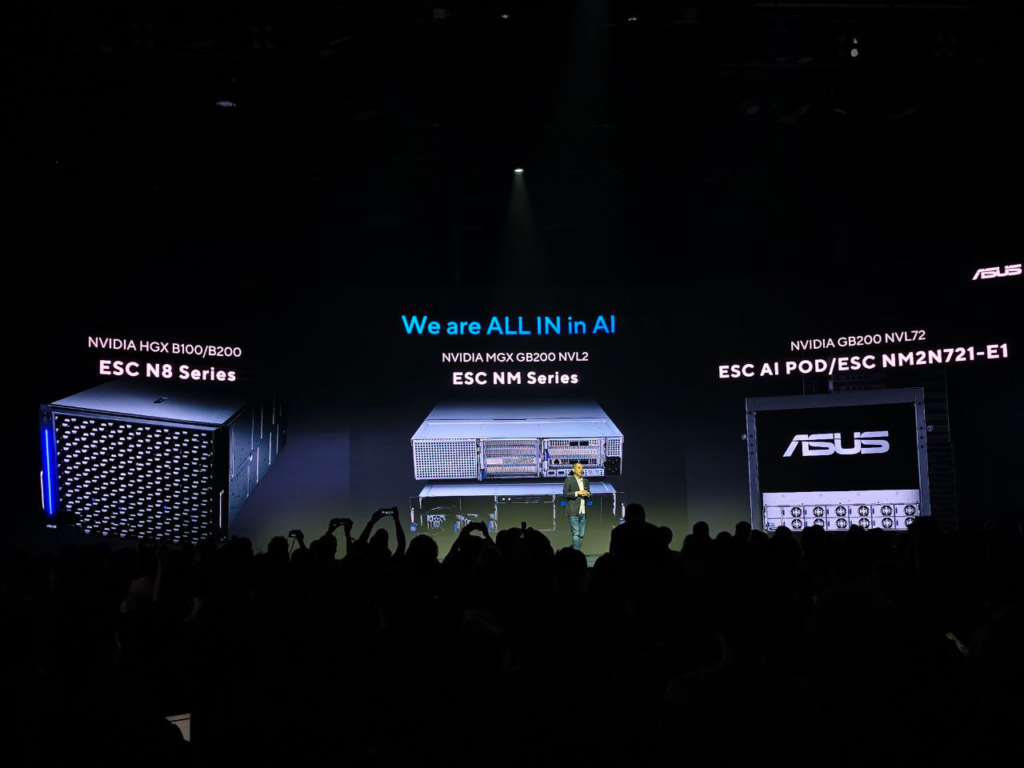

La siguiente figura de Asus esquematiza la solución del fabricante dueño de casa en Computex:

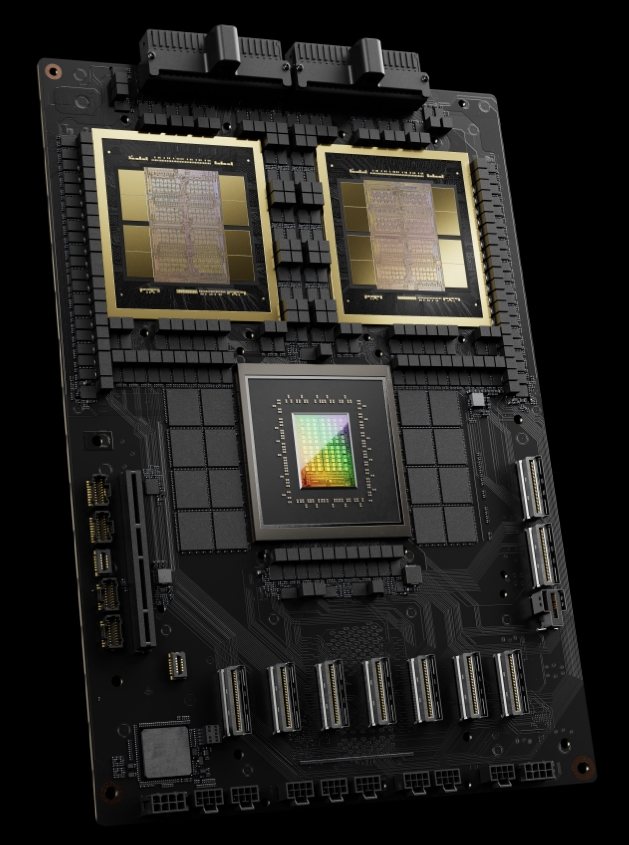

¿Cómo está compuesto el NVIDIA GB200 NVL72 que forma parte del ASUS ESC AI PO?

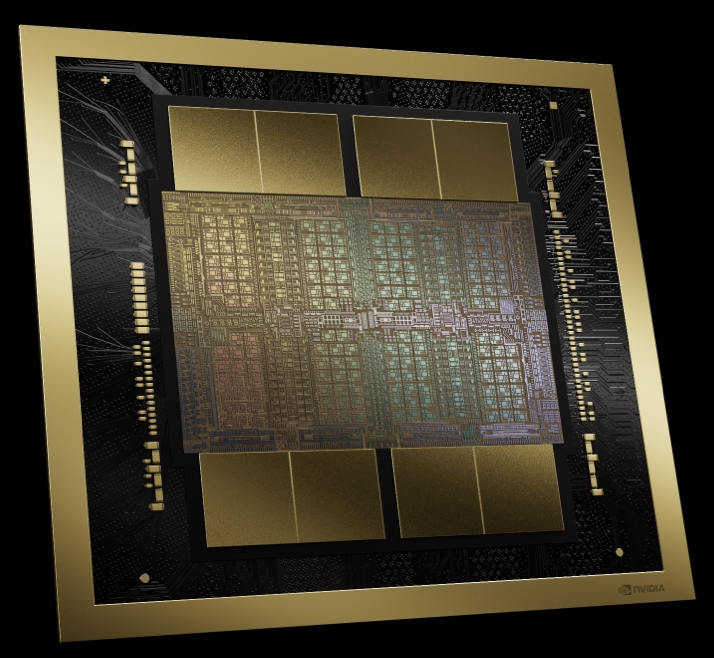

En marzo de este año el gigante de las GPU anunció la arquitectura NVIDIA Blackwell que permite correr y/o entrenar modelos de GenAI de billones de parámetros, con un consumo energético 25 veces menor a la versión anterior.

Para lo anterior, se creó un superchip llamado NVIDIA GB200 Grace Blackwell que su función es conectar dos GPU NVIDIA B200 Tensor Core mediante una conexión directa entre chips a través de NVLink que es de bajo consumo y tiene un ancho de banda de 900GB/s.

En la parte superior de la segunda figura, se ven las dos GPU B200 Tensor Core y más abajo una CPU Grace, que están un mismo chip (superchip) que NVIDIA llamó GB200 Grace Blackwell.

¿Por qué este súperchip es la clave? El GB200 es el base de todo el sistema multinodos NVIDIA GB200 NVL72, puede combinar hasta 36 de los superchips Grace Blackwell, es decir 36 CPUs Grace y 72 GPU, de ahí su nombre.

Este es el diagrama de un rack de ASUS en el que incluye la plataforma de NVIDIA, en el que cada bandeja de cálculo (son 18), representa la distribución del sistema multinodos NVIDIA GB200 NVL72, interconectados por NVLink de quinta generación.

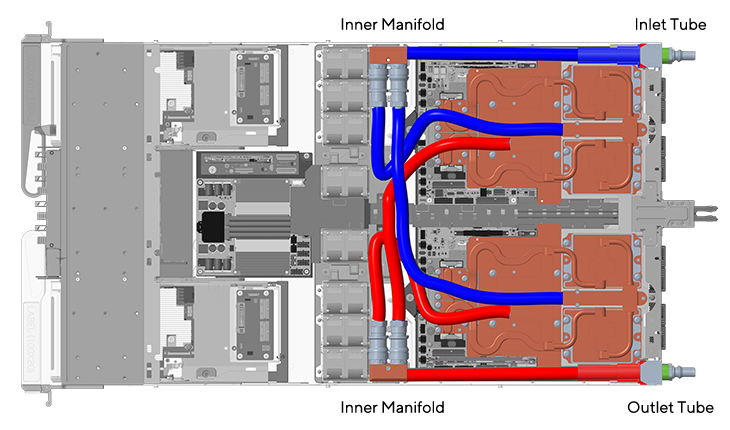

Y así sería el sistema de refrigeración líquida para cada bandeja (Compute Tray) del ASUS ESC AI POD.

¿Qué te parecen los anuncios realizados por Asus en la Computex de este año?