Hoy es el primer día oficial de la feria internacional Computex 2023, evento donde se muestran las últimas novedades de la computación. Y por supuesto estamos muy emocionados por ello, debido a que luego de 4 años la feria vuelve a ser presencial. Sin embargo, NVIDIA es una de las primeras empresas que han dado a conocer diversas novedades. Y en esta oportunidad, tiene relación con equipos para la computación de alto rendimiento (HPC o High Performance Computing). Por supuesto, vamos a conocer los anuncios.

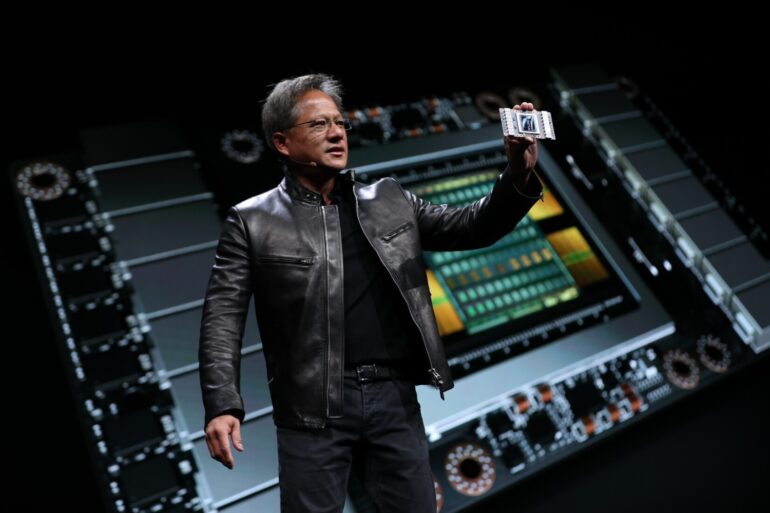

Superchip NVIDIA GH200 Grace Hopper

El primer gran anuncio tiene relación con el superchip llamado NVIDIA GH200 Grace Hopper, el cual está dedicado a ejecutar cargas de trabajo complejas de IA y HPC. El superchip es una combinación de GPU+CPU, el cual reúne las arquitecturas de GPU Hopper y CPU Grace basadas en Arm utilizando la tecnología de interconexión NVIDIA NVLink.

Gracias al protocolo NVLink, la comunicación entre CPU y GPU ofrece un ancho de banda total de hasta 900 GB/s, un ancho de banda 7 veces mayor que los carriles PCIe Gen5 estándar que se encuentran en los sistemas acelerados tradicionales, lo que brinda una increíble capacidad de cómputo para abordar las aplicaciones de HPC e IA más exigentes.

Adicionalmente, el NVIDIA GH200 Grace Hopper cuenta con 72 núcleos Arm y es capaz de mover 4 PetaFLOPS. El tamaño de su memoria HBM3 llega hasta 96 GB con un ancho de banda de hasta 4 TB/s, y la memoria de la GPU alcanza hasta 576 GB. También tiene un TDP variable según la demanda que varía entre 450 hasta 1000W y pueden ser refrigerados tanto por aire como líquido.

Supercomputador para inteligencia artificial DGX GH200

Si lo anterior te pareció sorprendente, déjame decirte que todavía se puede más. Resulta que la compañía ha presentado su nuevo supercomputador llamado NVIDIA DGX GH200 y está basado en la tecnología de superchips GH200 Grace Hopper.

El supercomputador ha sido creado para permitir el desarrollo de modelos gigantes de próxima generación para lenguaje de IA generativa, aplicaciones, sistemas de recomendación y grandes cargas de trabajo de análisis de datos.

El espacio de memoria compartida masiva del NVIDIA DGX GH200 utiliza la tecnología de interconexión NVLink (protocolo) con el sistema de conmutación NVLink Switch (dispositivo) para combinar hasta 256 superchips GH200, lo que les permite funcionar como una sola GPU. Esto proporciona 1 exaFLOPS de rendimiento y 144 terabytes (TB) de memoria compartida, casi 500 veces más memoria que la generación anterior NVIDIA DGX A100, que se presentó en el 2020.

DGX GH200 es el primer supercomputador que empareja los superchips Grace Hopper con NVIDIA NVLink Switch System, una nueva interconexión que permite que todas las GPUs (hasta 256) en un sistema DGX GH200 funcionen juntas como una sola. El sistema de la generación anterior solo permitía combinar 8 GPUs con NVLink como una sola GPU sin comprometer el rendimiento.

Además, la arquitectura DGX GH200 proporciona 48 veces más ancho de banda NVLink que la generación anterior, brindando la potencia de un supercomputador de IA masiva con la simplicidad de programar una sola GPU.

Algunas de las compañías que usarán este supercomputador son Google Cloud, Meta y Microsoft. Quienes se encuentran entre los primeros que obtengan acceso al DGX GH200 para explorar sus capacidades para cargas de trabajo generativas de IA. NVIDIA también tiene la intención de proporcionar el diseño DGX GH200 como modelo para los proveedores de servicios en la nube y otros hiperescaladores para que puedan personalizarlo aún más para su infraestructura.

NVIDIA MGX la nueva arquitectura modular para centros de datos

Otro elemento presentado por la empresa es NVIDIA MGX, elemento que proporciona a los fabricantes de sistemas una arquitectura de referencia modular para crear de forma rápida y rentable más de 100 variaciones de servidores para adaptarse a una amplia gama de aplicaciones de IA, computación de alto rendimiento y Omniverse.

Con NVIDIA MGX, los fabricantes comienzan con una arquitectura de sistema básica optimizada para computación acelerada para el chasis de su servidor y luego seleccionan su GPU, DPU y CPU. Las variaciones de diseño pueden abordar cargas de trabajo únicas, como HPC, ciencia de datos, modelos de lenguaje grandes, computación perimetral, gráficos y video, inteligencia artificial empresarial, diseño y simulación.

Existen múltiples tareas como el entrenamiento de IA y 5G que se pueden manejar en una sola máquina, mientras que las actualizaciones a futuras generaciones de hardware pueden realizarse sin problemas. NVIDIA MGX también se puede integrar fácilmente en la nube y los centros de datos empresariales.

MGX funciona con diferentes factores de forma y es compatible con las generaciones actuales y futuras de hardware NVIDIA, que incluyen:

- Chasis: 1U, 2U, 4U (refrigeración por aire o líquido)

- GPU: cartera completa de GPU NVIDIA, incluidas las últimas H100, L40, L4

- CPU: Superchip NVIDIA Grace CPU, superchipGH200 Grace Hopper, CPU x86

- Redes: adaptadores de red NVIDIA DPU BlueField-3 o ConnectX-7.

MGX se diferencia de NVIDIA HGX en que ofrece compatibilidad multigeneracional flexible con productos NVIDIA para garantizar que los creadores de sistemas puedan reutilizar diseños existentes y adoptar fácilmente productos de próxima generación sin rediseños costosos. Por el contrario, HGX se basa en una placa base multi-GPU conectada a NVLink adaptada a la escala para crear lo último en sistemas de IA y HPC.

Plataforma NVIDIA Spectrum-X, Ethernet acelerado para IA

Terminando con los anuncios orientados a la computación de alto rendimiento, encontramos la plataforma NVIDIA Spectrum-X. Esta es una plataforma de red acelerada diseñada para mejorar el rendimiento y la eficiencia de las nubes de IA basadas en Ethernet.

Así mismo, la plataforma está basada en los siguientes componentes: El conmutador o Switch Ethernet NVIDIA Spectrum-4, junto a la Unidad de Procesamiento de Datos (DPU) llamada NVIDIA BlueField-3. Con esto se logra un rendimiento general de IA y eficiencia energética 1,7 veces mejores, junto con un rendimiento constante y predecible en entornos multiusuarios. Spectrum-X está potenciado por el software de aceleración de NVIDIA y los kits de desarrollo de software (SDK), lo que permite a los desarrolladores crear aplicaciones de IA nativas de la nube y definidas por software.

La entrega de capacidades de extremo a extremo reduce los tiempos de ejecución de los modelos masivos de IA generativa basados en transformadores. Esto permite que los ingenieros de redes, los científicos de datos de IA y los proveedores de servicios en la nube mejoren los resultados y tomen decisiones informadas más rápido.

La plataforma de red NVIDIA Spectrum-X es muy versátil y se puede utilizar en varias aplicaciones de IA. Utiliza Ethernet totalmente basada en estándares y es interoperable con pilas basadas en Ethernet.

Del mismo modo, la plataforma comienza con Spectrum-4, el primer Switch Ethernet de 51 Tb/seg del mundo construido específicamente para redes de IA. Las extensiones avanzadas de RoCE funcionan al mismo tiempo en los conmutadores Spectrum-4, las DPU BlueField-3 y la óptica NVIDIA LinkX crean una red de hasta 400 GbE (tarjetas de red) de extremo a extremo que está optimizada para las nubes de IA.

Un dato no menor, es que la DPU BlueField-3 cuenta con puertos de red Ethernet y NDR que alcanzan hasta 400 Gbps. A su vez la “tarjeta de red” incluye 32 GB de memoria de tipo DDR5 a 5.600 MT/s, tiene interfaz PCIe 5.0 de 32 carriles y su procesador Arm tiene hasta 16 núcleos con 8 MB de caché L2.

NVIDIA Spectrum-X permite una escala sin precedentes de 256 puertos de 200 Gb/s conectados por un solo conmutador, o 16 000 puertos en una topología de columna vertebral de hoja de dos niveles para respaldar el crecimiento y la expansión de las nubes de IA mientras se mantienen altos niveles de rendimiento y se minimiza la latencia de la red.

Finalmente, se espera que estos potentes elementos para la computación de alto rendimiento (HPC) estén disponibles a finales de este año.

¿Qué te parece lo presentado por NVIDIA en el Computex 2023?