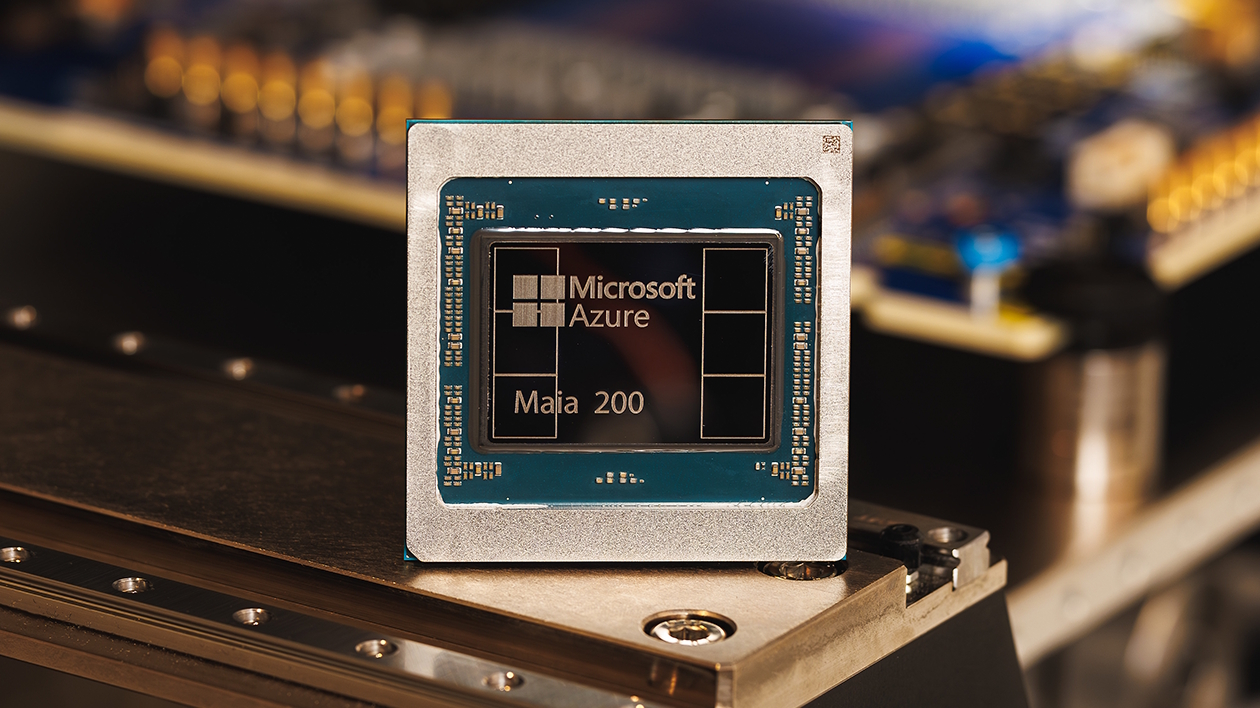

Microsoft anunció los detalles detrás de la arquitectura del Maia 200, un acelerador diseñado para ejecutar tareas de inferencia en modelos de lenguaje extenso. Este componente optimiza el procesamiento de datos dentro de los data centers de Microsoft (la infraestructura de Azure).

Arquitectura de silicio optimizada para modelos de lenguaje

La unidad de procesamiento utiliza la tecnología de fotolitografía N3P de 3nm . Esta elección permite integrar una densidad de transistores crítica para gestionar las cargas de trabajo computacionales extremadamente pesadas en entornos cloud.

El procesador cuenta con núcleos tensoriales nativos que operan con formatos de precisión reducida FP8 y FP4. El diseño permite gestionar cargas de trabajo de miles de millones de parámetros optimizando el consumo energético del chip.

El procesador utiliza una red interna denominada AI fabric que mantiene un suministro de datos constante hacia los núcleos. Este diseño elimina los tiempos de inactividad, logrando que el hardware trabaje a plena capacidad sin pausas logísticas.

Rendimiento comparativo con la TPU de Google Cloud y Trainium3 de AWS.

El rendimiento del Maia 200 supera a las soluciones actuales de Google y AWS en el manejo de formatos de punto flotante comprimidos (FP8 y FP4). Esta capacidad permite ejecutar modelos complejos con una agilidad superior a la de los procesadores de la competencia.

El sistema de memoria utiliza tecnología HBM3e con un ancho de banda que alcanza los 7 TB/s, tal como lo hace la competencia. Esta velocidad es crítica para alimentar las unidades de procesamiento con los datos necesarios sin generar latencia.

Veámoslo de este modo: la HBM3e se puede comparar con un acueducto muy grande que alimente de agua la ciudad completa, y de manera constante. De ahí que el ancho de banda de la HBM3e sea enorme; por ende, como no existen restricciones en el conducto, todos los sectores reciben el recurso necesario sin interrupciones ni demoras.

Especificaciones de hardware y escalabilidad de Microsoft Maia 200

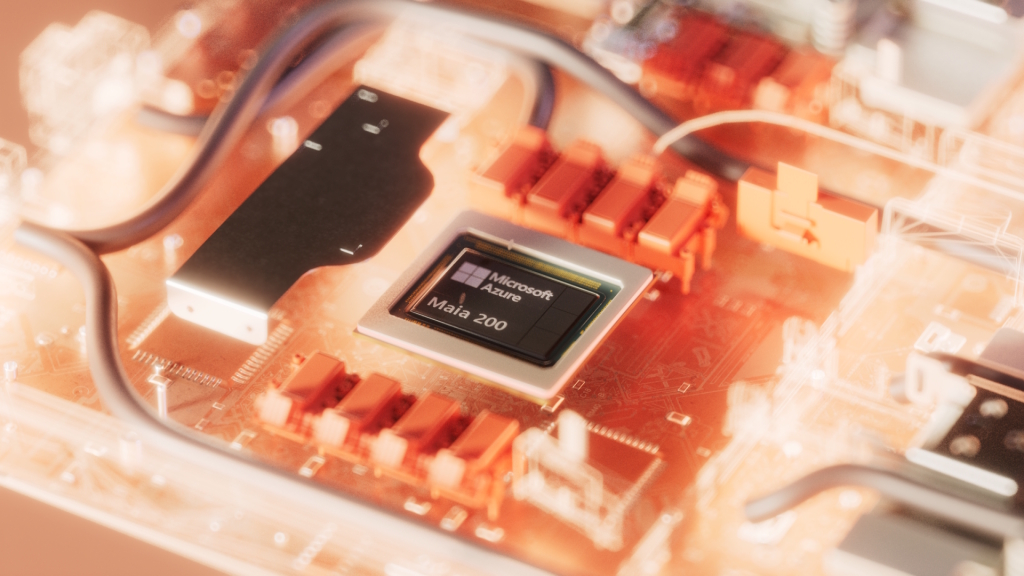

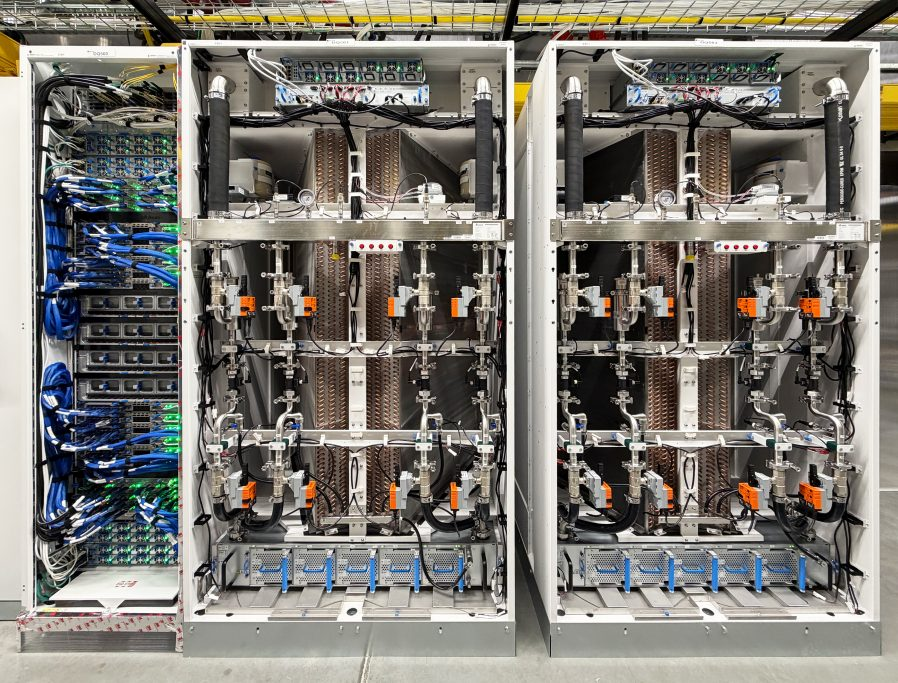

El diseño físico del Maia 200 dispone de un sistema de refrigeración líquida para gestionar una potencia térmica de 750 vatios. Esto le permite garantizar la estabilidad necesaria para procesar volúmenes masivos de información 24/7.

La idea detrás de la refrigeración es evitar el agotamiento del chip por aumento de la temperatura. Por ende, es que al contar con una líquida, el silicio puede operar sin detenerse.

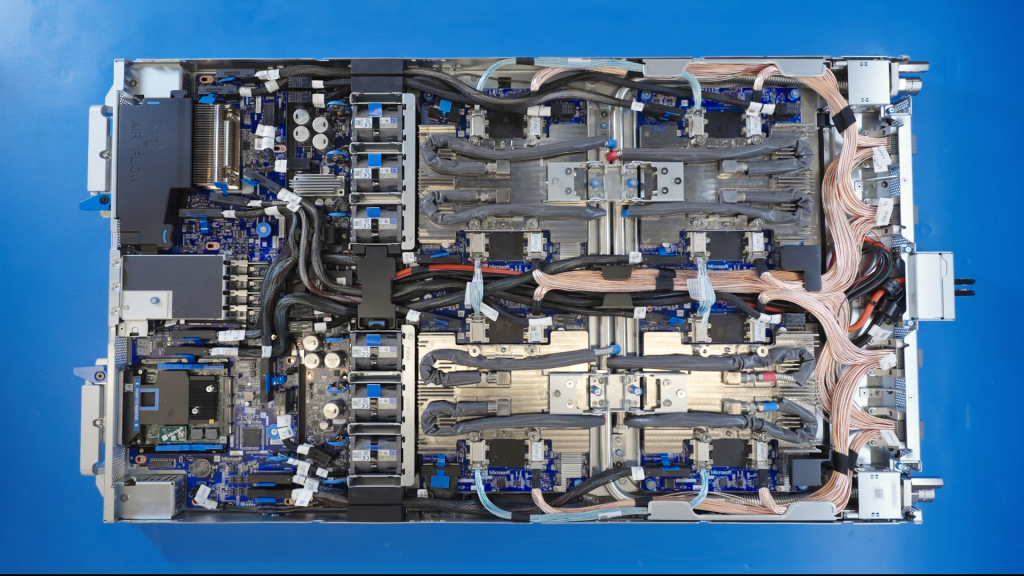

El procesador Maia 200 se integra en un blade que optimiza la entrega de energía y la conectividad. Esta unidad modular permite un mantenimiento simplificado y una alta densidad de componentes dentro de los racks.

El sistema de refrigeración líquida Sidekick bombea refrigerante directamente a los chips para gestionar un consumo térmico de 750 vatios. Este mecanismo asegura que el hardware mantenga temperaturas operativas óptimas incluso bajo estrés computacional máximo.

La red de interconexión utiliza protocolos de transporte de IA sobre una base de Ethernet para escalar miles de unidades. Este sistema facilita la comunicación masiva entre nodos sin depender de tecnologías de red propietarias.

Esta particularidad es propia de todas las arquitecturas de los hiperescaladores, y funciona como una flota de varios miles de camiones coordinados por un sistema central que evita cualquier congestión en las rutas. Esta sincronización garantiza que todos los vehículos lleguen a su destino exactamente al mismo tiempo.

Ecosistema de software y despliegue técnico

El aprovechamiento del hardware se facilita mediante el Maia SDK, que integra herramientas de compilación para entornos como PyTorch y Triton. Esta pila tecnológica permite mover o importar modelos existentes sin necesidad de reescribir el código, en la mayoría de los casos.

La idea del conjunto es actuar como un adaptador universal que permite conectar dispositivos complejos en cualquier red eléctrica del mundo. Los desarrolladores pueden centrarse en la lógica de sus modelos mientras el software optimiza la ejecución física.

Scott Guthrie, vicepresidente ejecutivo de Cloud y AI de Microsoft, describió los pilares que definen el diseño de este nuevo ecosistema de silicio.

“Maia 200 es una potencia en inferencia de IA: un acelerador construido sobre el proceso de 3nm de TSMC con núcleos tensoriales nativos FP8/FP4, un sistema de memoria rediseñado con 216GB HBM3e a 7 TB/s y 272MB de SRAM integrada, además de motores de movimiento de datos que mantienen los modelos masivos alimentados, rápidos y con una alta utilización.”.

Scott Guthrie, vicepresidente ejecutivo de Cloud y AI de Microsoft