Google Cloud incorporó nuevos procesadores personalizados a su infraestructura: las TPU Ironwood, séptima generación de su línea de aceleradores para inteligencia artificial, y las instancias Axion, basadas en arquitectura Arm. Ambas tecnologías están orientadas a mejorar el rendimiento y la eficiencia del cómputo en tareas de entrenamiento e inferencia de modelos de gran escala.

Ambas soluciones responden al cambio de foco que vive la industria:

- El paso del entrenamiento de modelos a la etapa de inferencia.

- La búsqueda de mayor escalabilidad y eficiencia operativa.

- La necesidad de soportar sistemas de IA generativa.

- La optimización de flujos de trabajo agénticos.

En esta etapa, los sistemas de inteligencia artificial requieren una mayor integración entre el cómputo general y los aceleradores especializados. La propuesta de Google se apoya en un diseño coordinado de hardware, redes y software para optimizar el uso de recursos y mantener un rendimiento estable en modelos fundacionales y LLM de gran escala.

¿Qué aporta Ironwood a la infraestructura de IA?

Las TPU Ironwood están diseñadas para ejecutar tareas de entrenamiento, inferencia y aprendizaje por refuerzo en entornos de alta complejidad.

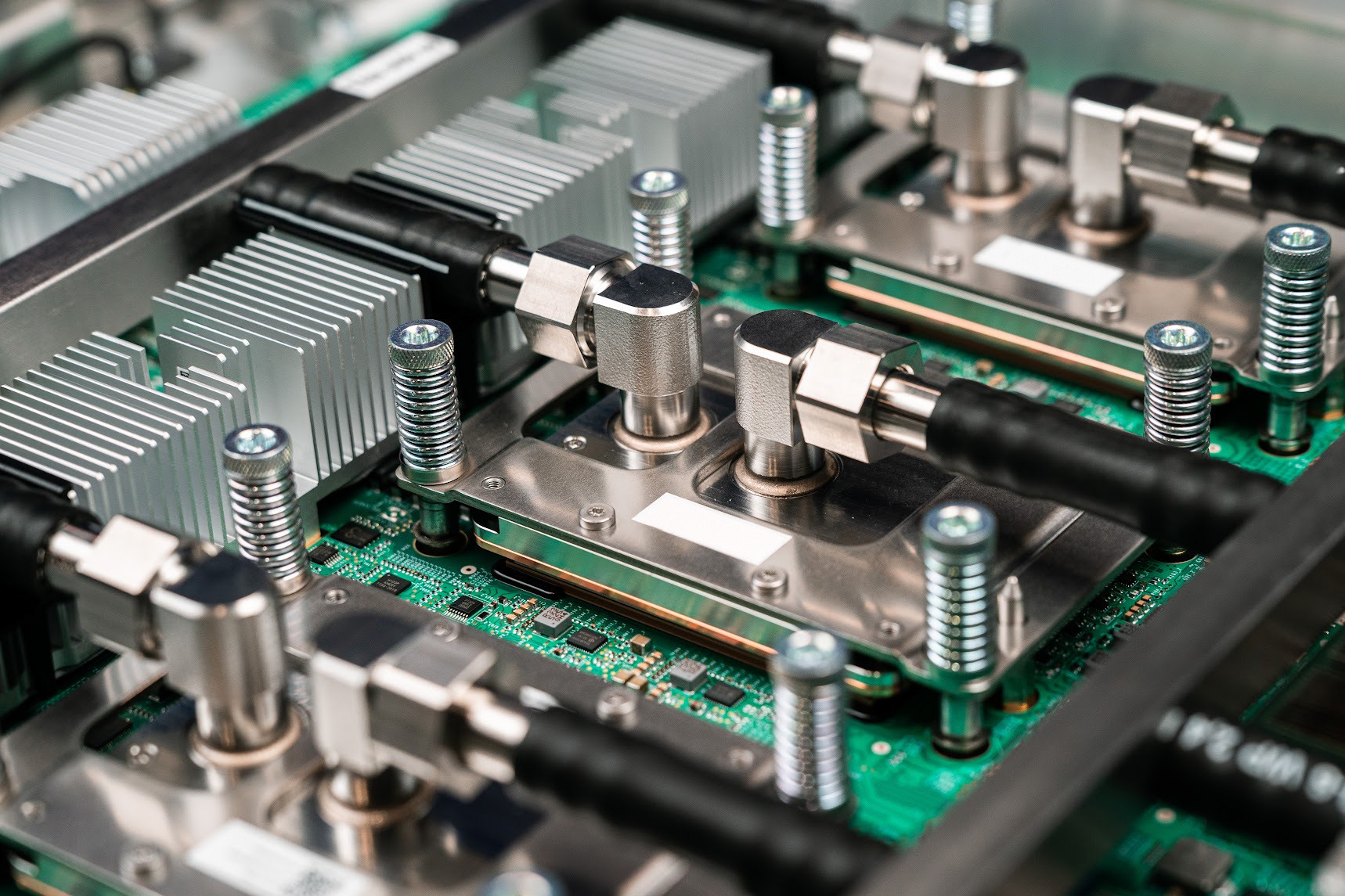

El desarrollo de la aquictectura se basa en una arquitectura personalizada que combina mejoras en potencia de cómputo, eficiencia energética y escalabilidad dentro del sistema AI Hypercomputer, una infraestructura que unifica cómputo, almacenamiento y red bajo un diseño coherente.

Google define AI Hypercomputer como un sistema integrado de supercomputación pensado para optimizar el trabajo con inteligencia artificial y aprendizaje automático. Combina hardware de alto rendimiento, software abierto y marcos de aprendizaje automático, permitiendo ajustar los recursos según las necesidades de cada proyecto.

Arquitectura bajo las TPU Ironwood:

- Hasta 10 veces más rendimiento pico respecto de TPU v5p.

- Más de 4 veces mejor rendimiento por chip frente a TPU v6e (Trillium).

- Escalabilidad de hasta 9.216 chips interconectados por superpod.

- 1,77 petabytes de memoria HBM compartida con red Inter-Chip Interconnect (ICI) de 9,6 Tb/s.

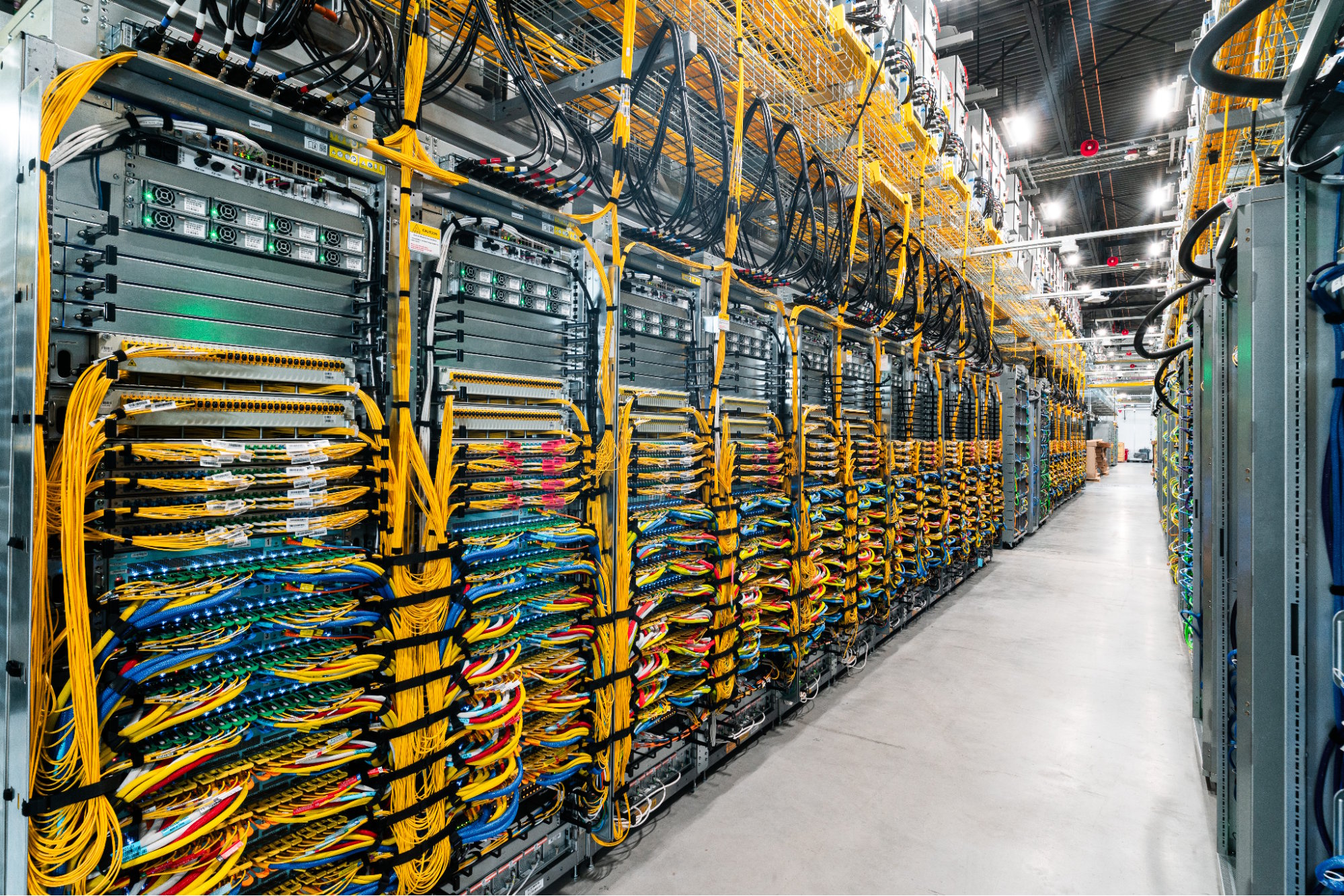

- Uptime promedio de 99,999 % desde 2020 en operaciones de data center.

Esta arquitectura permite trabajar con modelos multimodales y ejecutar procesos de inferencia a gran escala sin que el acceso a los datos se convierta en un cuello de botella.

Además, incorpora Optical Circuit Switching (OCS), una red óptica que redirige automáticamente las tareas ante fallos o interrupciones, lo que ayuda a mantener los servicios operativos sin intervención manual.

En términos simples, es como si una ciudad digital tuviera miles de avenidas por donde circulan datos. Cuando una calle se congestiona o se corta, el sistema abre una ruta alternativa al instante para que el tráfico siga fluyendo sin detenerse. De esa forma, los modelos de inteligencia artificial pueden seguir trabajando sin que los datos queden atrapados en un embotellamiento.

Axion: cómputo general sobre arquitectura Arm

La segunda novedad de la compañía es la expansión de su línea Axion, procesadores basados en la arquitectura Arm Neoverse que apuntan a tareas de cómputo general, servicios de backend y procesamiento de datos complementarios a los flujos de IA.

El objetivo es ofrecer alternativas de menor costo energético y mayor flexibilidad frente a los entornos basados en x86:

- N4A (vista previa): hasta 64 vCPUs, 512 GB DDR5 y 50 Gbps de red.

- C4A Metal (vista previa próxima): hasta 96 vCPUs, 768 GB DDR5 y 100 Gbps para cargas especializadas.

- Compatibilidad con Hyperdisk Balanced, Throughput y Extreme.

- Soporte para almacenamiento local de hasta 6 TB en SSD Titanium.

El conjunto Axion busca optimizar cargas de microservicios, bases de datos abiertas, entornos de desarrollo y sistemas de simulación. En combinación con Ironwood, conforma una arquitectura de cómputo heterogénea donde los aceleradores se encargan del procesamiento intensivo y las CPUs gestionan las operaciones de soporte, la ingesta de datos y los servicios de aplicación.