Uno de los aspectos ocultos de la carrera mundial por la IA es quién trabaja con qué procesadores, o chips. El desarrollador de IA con el procesador más rápido y optimizado tendrá una enorme ventaja sobre cualquiera que utilice un procesador obsoleto. Ahora, Google afirma que su última generación de chips Tensor, o Unidades de Procesamiento Tensor (UPT), es la más rápida, la más eficiente energéticamente y la más optimizada para las tareas con IA.

Actualmente, todos los grandes estudios de software utilizan los procesadores A100 de NVIDIA. Los chips A100 son los más utilizados por los estudios de desarrollo para las cargas de trabajo de IA y aprendizaje automático. Google afirma que sus últimos chips Tensor superan a la oferta de NVIDIA en todos los aspectos. Por muy buenos que sean los procesadores A100 de NVIDIA, no son lo mejor que pueden ofrecer: eso será el H100.

Lo nuevo de los procesadores Tensor

Google ha revelado recientemente nueva información sobre los superordenadores que utiliza para enseñar sus modelos de inteligencia artificial, afirmando que los sistemas son a la vez más rápidos y eficientes desde el punto de vista energético que los sistemas similares de Nvidia.

Google creó su propio procesador especial, conocido como Tensor Processing Unit (TPU). Utilizándolos para más del 90% de las tareas de inteligencia artificial de la empresa, que es el proceso de introducir datos en modelos para hacerlos utilizables.

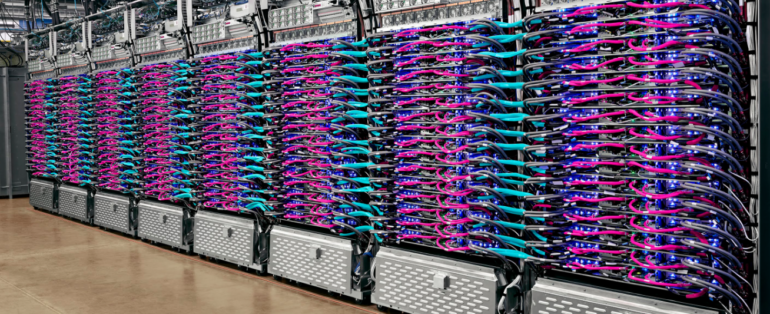

El martes pasado, Google publicó un artículo en el que explicaba cómo había conectado más de 4.000 chips a un supercomputador utilizando sus propios conmutadores ópticos personalizados para enlazar las máquinas.

Dado que los grandes modelos que alimentan tecnologías como Bard de Google o ChatGPT de OpenAI se han disparado en tamaño, son demasiado grandes para alcanzar en un solo chip. A raíz de lo anterior, es que mejorar estas conexiones se haya convertido en un punto crucial de rivalidad entre las empresas que crean supercomputadores de IA. Para esto, es que Google ya ha llevado sus TPUs a la cuarta versión entre todas las pruebas que han realizado en esta búsqueda por liderar las tareas relacionadas con la IA.

Un poco de historia del proyecto de Google

Aunque Google solo está revelando información sobre su supercomputador ahora, ha estado operativo desde 2020 en un centro de datos en el condado de Mayes, Oklahoma. Google declaró que el sistema fue utilizado por la startup Midjourney para entrenar su modelo, que crea nuevas imágenes tras recibir unas líneas de texto.

Según el estudio, los chips de Google son hasta 1,7 veces más rápidos y 1,9 veces más eficientes energéticamente que un sistema construido con el chip A100 de Nvidia, que estaba en el mercado al mismo tiempo que la TPU de cuarta generación.

Google ha declarado que no ha comparado su procesador de cuarta generación con el chip H100 de Nvidia, el mejor del momento, porque el H100 se introdujo después que el chip de Google y utiliza una tecnología más reciente.

Google insinuó que estaba trabajando en un nuevo TPU para competir con el Nvidia H100, pero no dio más información. Lo único que dijeron es que tienen una buena línea de chips en preparación.