En las noticias sobre tecnología se ha vuelto común escuchar términos como supercomputación y centros de datos. También aparecen, aunque con menor frecuencia, expresiones como Computación de Alto Rendimiento (HPC) y Workstation.

Incluso el concepto de Exaflops se consolida como nueva frontera, asociado al avance de superPCs y sistemas capaces de realizar 10^18 operaciones por segundo. Todos estos términos están vinculados, pero se utilizan de manera intercambiable, lo que induce a errores.

Estos conceptos están relacionados dentro de la infraestructura tecnológica moderna. Sin embargo, el problema radica en que a menudo se utilizan de manera intercambiable a veces, como sinónimos, lo que genera confusión en su verdadero alcance.

El rango va desde estaciones de trabajo que procesan simulaciones de elementos finitos en ingeniería automotriz hasta sistemas exaescala capaces de ejecutar 10^18 operaciones de coma flotante por segundo. La primera responde a la productividad individual y la segunda a la resolución de problemas globales, como modelación del cambio climático.

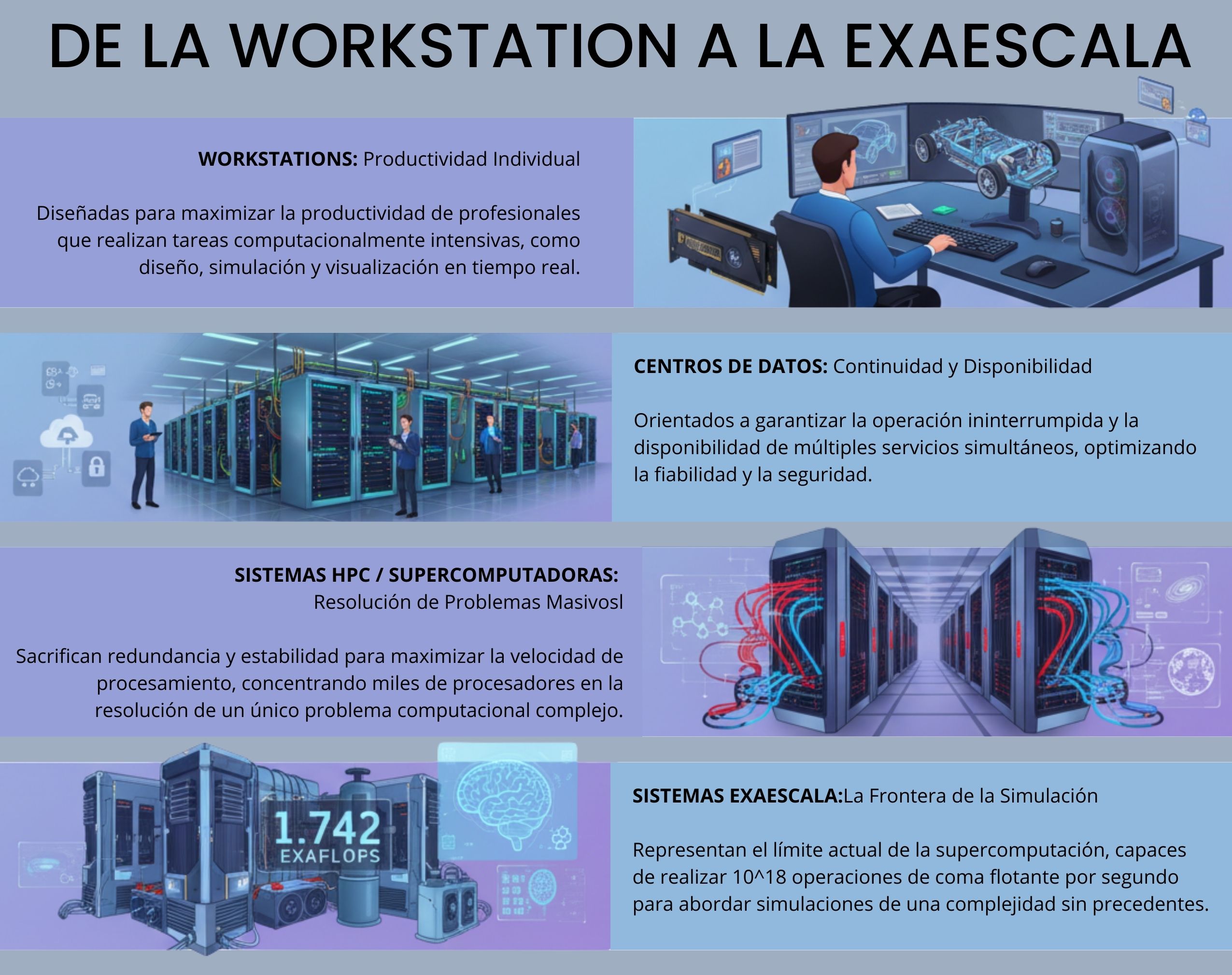

Una infografía inicial WorkStation al Exaflop

Cada infraestructura responde a objetivos fundamentalmente diferentes:

- Las workstations están diseñadas para maximizar la productividad individual de profesionales que realizan tareas computacionalmente intensivas.

- Los centros de datos están diseñados para garantizar continuidad operativa y disponibilidad de múltiples servicios simultáneos, optimizando para que nunca fallen.

- Los sistemas HPC o supercomputadoras sacrifican la redundancia y estabilidad para maximizar la velocidad de procesamiento, concentrando miles de procesadores en resolver un único problema computacional complejo

- Los sistemas exaescala representan la frontera actual de la supercomputación, capaces de realizar 10^18 operaciones de coma flotante por segundo para abordar simulaciones de una complejidad sin precedentes.

La convergencia en plataformas de nube pública está transformando el acceso a estos recursos. El paso de la infraestructura propia al consumo bajo demanda, conocido como HPCaaS, marca un cambio estructural en la investigación científica y la innovación tecnológica.

La herramienta del profesional: La WorkStation de alto rendimiento o SuperPC individual

Si el centro de datos es la ciudad digital, la workstation es el taller especializado del profesional, y por lo general el computador más poderoso de una oficina.

La estación de trabajo, es un PC de alto rendimiento pensado para un único usuario que enfrenta tareas intensivas como:

- Diseño y modelado 3D en software CAD como AutoCAD, SolidWorks o Catia.

- Renderizado 3D y animación en motores como Blender, Maya o 3ds Max.

- Edición y posproducción de video en resoluciones 4K, 8K o superiores con DaVinci Resolve, Adobe Premiere o Avid.

- Simulación de elementos finitos (FEA) en ingeniería mecánica y estructural.

- Dinámica de fluidos computacional (CFD) para modelar flujos en automoción, aeronáutica o energía.

- Análisis y visualización de datos científicos en bioinformática, genómica o física computacional.

- Reconstrucción y análisis de imágenes médicas (TAC, RMN, PET).

- Desarrollo y entrenamiento de modelos de inteligencia artificial en entornos locales, usando GPUs de propósito profesional.

- Simulaciones financieras para análisis de riesgos, algoritmos de trading o pronósticos de mercado.

- Creación de entornos de realidad virtual y aumentada, con soporte para motores gráficos de alto rendimiento.

Por las aplicaciones posibles que tiene, claramente está pensado para maximizar la productividad individual.

De manera particular, se diferencia de la HPC, ya que esta concentra recursos en cálculos paralelos masivos, la workstation está ideada en la interacción directa y en eliminar cualquier cuello de botella que afecte el flujo de trabajo.

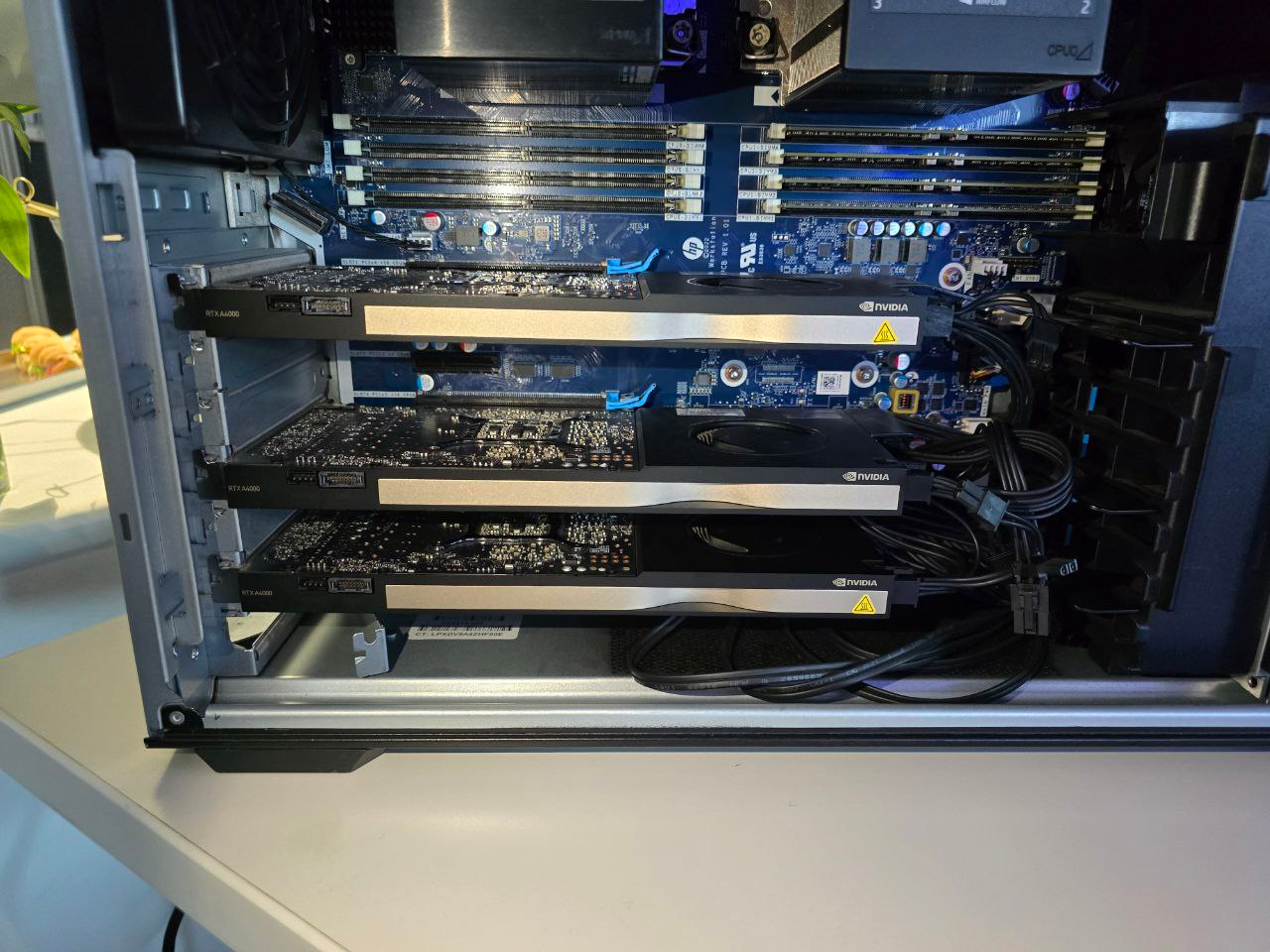

Componentes claves de una Workstation

Lo que separa a una workstation de un PC normal es:

- Potencia bruta.

- Fiabilidad sostenida bajo cargas continuas.

- Certificación para software profesional asegura compatibilidad y estabilidad en aplicaciones críticas.

Sus componentes clave incluyen:

- Procesadores de clase servidor como Intel Xeon o AMD Ryzen Threadripper, ideas para cargas intensivas,

- GPUs profesionales NVIDIA RTX Ada Generation, con drivers optimizados para aplicaciones como AutoCAD, SolidWorks o DaVinci Resolve.

- Las memorias RAM ECC

La memoria RAM ECC (Error-Correcting Code) marca la diferencia entre una herramienta profesional y una máquina de consumo. Puede detectar y corregir errores de un solo bit en tiempo real, algo indispensable en simulaciones financieras, cálculos científicos o renderizado avanzado.

Como analogía particular:

El PC que está en casa, es como el auto familiar, ideal para ir al trabajo, hacer las compras y llevar a la familia. Es fiable, económico y cumple con todas las necesidades del día a día.

Por su parte, el PC Gamer de primer nivel, es un auto de lujo superdeportivo al puro estilo Ferrari. Su concepto es ofrecer potencia, velocidad y rendimiento para juegos. Es muy rápido, muy costoso y tiene una estética particular que puede o no gustar.

La Workstation es la bestia de trabajo pesado y continuo, es un camión de carga industrial o una maquinaria pesada. No es el más rápido en una carrera corta ni el más cómodo para un paseo, pero está construido para trabajar sin parar, mover cargas masivas (datos) con total fiabilidad y durar años bajo condiciones extremas.

El cimiento de todo: El centro de datos o data center

El centro de datos en sí es un inmueble que concentra toda la capacidad técnica y de infraestructura TI para operar datos de manera continua.

El objetivo de estas infraestructuras está pensando para tener respaldos y enfrentar situaciones de emergencia pensando en la redundancia de los elementos: desde la acometida eléctrica hasta los sistemas de archivos.

Se tiene por principio que el costo de la inactividad puede superar millones de dólares por hora en grandes corporaciones, por lo que la continuidad operacional es el objetivo central.

Infraestructura Física: Los sistemas de soporte vital

Los centros de datos se sustentan en infraestructura física crítica que garantiza un entorno operativo estable para los equipos de TI. Esta arquitectura de soporte incluye múltiples sistemas especializados que funcionan de manera coordinada:

Un data center no depende solo de servidores y cables. Su estabilidad depende de un entramado físico capaz de proveer energía ininterrumpida, refrigeración avanzada, protección ante incidentes, entre otros.

Así se los planteábamos comentando sobre nuestra visita al data center de Ascenty hace algunos días, una infraestructura:

Con certificación Tier III, con un 99.982% de disponibilidad, lo que equivale a un máximo de 1,6 horas de inactividad no planificada al año.

Sistemas Eléctricos:

- Acometidas eléctricas redundantes desde diferentes subredes

- UPS (Sistemas de Alimentación Ininterrumpida) con bancos de baterías

- Grupos electrógenos diésel para respaldo de larga duración

- Sistemas de distribución eléctrica con doble alimentación

Climatización y Control Ambiental:

- CRAC/CRAH (unidades de aire acondicionado para salas de ordenadores)

- Intercambiadores de calor de puerta trasera (RDHX) para racks de alta densidad

- Refrigeración líquida directa al chip (direct-to-chip cooling)

- Refrigeración por inmersión líquida con fluidos dieléctricos

- Sistemas de monitorización de temperatura y humedad

Seguridad y Protección:

- Perímetros de seguridad física multicapa

- Control de acceso biométrico y tarjetas de proximidad

- Sistemas de videovigilancia y detección de intrusión

- Detección y extinción de incendios con gases inertes

- Protección contra inundaciones y desastres naturales

- Protección contra sismos

Aisladores sísmicos del data center SAN de Cirion en Chile

Un caso particular son los aisladores sísmicos de péndulo friccional de TİS Teknolojik İzolatör Sistemleri, instalados en el Data Center SAN de Cirion en Chile.

Estos dispositivos alargan el periodo de vibración de la estructura (o aumentan el periodo de oscilación gracias al aislador) permitiendo que las aceleraciones transmitidas a la estructura disminuyan, y como consecuencia, los esfuerzos sísmicos también se reducen.

Los aisladores de TIS, cuentan con un mecanismo pendular y, al mismo tiempo, disipan energía gracias a superficies de fricción como teflón sobre acero inoxidable.

Modelos de despliegue y métricas Clave

Los centros de datos pueden gestionarse bajo distintos modelos, y cada uno responde a necesidades empresariales específicas. La elección define:

- Cuánto control se tendrá.

- La inversión necesaria.

- Grado de flexibilidad operativa disponible.

La excelencia operativa se mide mediante dos métricas fundamentales:

- La clasificación Tier (donde Tier IV garantiza 99.995% de disponibilidad equivalente a 26.3 minutos máximo de inactividad anual)

- El PUE que evalúa eficiencia energética, donde los proveedores de nube alcanzan valores de 1.1 frente al promedio industrial de 1.58.

El poder del colectivo: La computación de Alto Rendimiento (HPC) o Supercomputación

La HPC es una nueva forma en que se maneja la información, está orientada hacia la investigación, y por lo general se encuentran en universidades o grandes laboratorios. Como es el caso de los HPC Leftraru Epu y Guacolda en la Universidad de Chile.

En lugar de muchas tareas para muchos usuarios, se concentran miles de procesadores en la resolución de un único problema masivo. Su foco es reducir el tiempo hasta la solución en desafíos como:

- Medicina personalizada y genómica: análisis de secuencias de ADN a gran escala, simulación de proteínas y predicción de mutaciones para terapias dirigidas.

- Ciencia de materiales: modelado cuántico para diseñar aleaciones resistentes, nuevos semiconductores o baterías de mayor densidad energética.

- Ingeniería aeronáutica y automotriz: dinámica de fluidos computacional (CFD) para optimizar la aerodinámica de aviones y vehículos, reduciendo consumo de combustible.

- Exploración energética: simulación de yacimientos petroleros o campos geotérmicos, y modelado de celdas solares de próxima generación.

- Seguridad nacional y criptografía: análisis de patrones en grandes volúmenes de datos, simulación de armas nucleares sin pruebas físicas y descifrado de algoritmos complejos.

- Inteligencia artificial y machine learning: entrenamiento de modelos de IA a gran escala, incluyendo LLMs y redes neuronales profundas, en plazos más cortos.

- Ciencias sociales computacionales: simulaciones de comportamiento poblacional, tráfico urbano o mercados financieros para prever dinámicas colectivas.

- Astronomía y cosmología: recreación de la evolución del universo, detección de ondas gravitacionales y análisis de datos de telescopios de nueva generación.

- Industria del entretenimiento: renderizado de películas de animación en estudios que requieren decenas de miles de núcleos en paralelo.

- Sismología e ingeniería civil: simulación de terremotos y evaluación de estructuras críticas como puentes, represas y centrales nucleares bajo escenarios extremos.

Diferencias entre una WorkStation y un HPC

La computación de alto rendimiento (HPC) se distingue de una WorkStation o super PC individual porque está diseñada para resolver problemas a gran escala. A su vez, la HPC puede entenderse como un Supercomputador colectivo, donde varios de nodos trabajan de forma coordinada en un mismo cálculo.

La arquitectura más común en HPC es el clúster, un conjunto de servidores interconectados que operan como un único superordenador gracias a una red de alta velocidad.

A diferencia de los centros de datos tradicionales, que priorizan la disponibilidad continua y la redundancia, los clústeres HPC sacrifican estabilidad para maximizar el rendimiento colectivo.

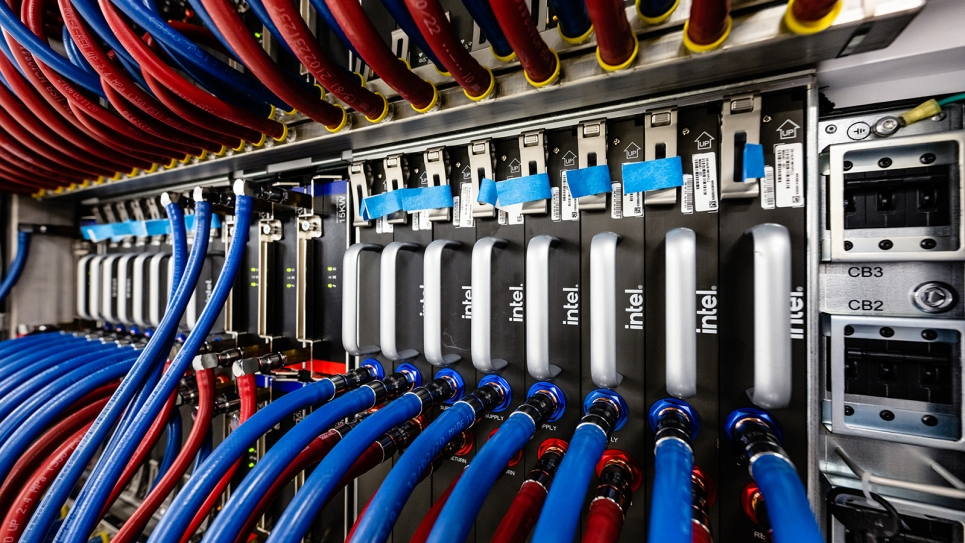

Componentes del Ecosistema HPC

Los sistemas HPC descansan en tres pilares fundamentales:

- Nodos de Cómputo: cientos o miles de servidores headless, a menudo híbridos, que combinan CPUs multinúcleo con GPUs aceleradoras como NVIDIA H100 o AMD Instinct.

- Sistema de Archivos Paralelo: soluciones como Lustre o IBM Spectrum Scale que distribuyen datos en múltiples servidores, permitiendo lecturas y escrituras simultáneas a terabytes por segundo.

- Red de Interconexión: el componente crítico que distingue un superordenador de una simple colección de servidores. Tecnologías como InfiniBand (hasta 800 Gb/s) o HPE Slingshot ofrecen baja latencia y alto ancho de banda, habilitando RDMA para acceso directo entre memorias.

El ecosistema se completa con el planificador de trabajos, que actúa como cerebro del clúster al gestionar la cola de tareas y optimizar la asignación de recursos.

El rendimiento de la HPC se mide en FLOPS (operaciones de coma flotante por segundo), con una escala que va desde Gigaflops (10⁹) hasta la frontera actual de Exaflops (10¹⁸).

El caso Chileno: NLHPC y el Supercomputador Leftraru Epu

El Laboratorio Nacional de Computación de Alto Rendimiento (NLHPC) muestra cómo Chile ha logrado consolidar capacidades HPC de clase mundial. Ubicado en el Centro de Modelamiento Matemático de la Universidad de Chile, es hoy la principal plataforma de supercomputación científica del país, dando soporte a 44 instituciones académicas y de investigación.

Leftraru Epu (Lautaro 2 en mapudungún), fue inaugurada en junio de 2024 y constituye la tercera generación del proyecto iniciado en 2009. Con una arquitectura basada en 27 nodos Lenovo ThinkSystem SR645 V3 y 2 nodos SR675 V3, todos equipados con procesadores AMD EPYC 9754 Bergamo, alcanza un rendimiento de 260 TFlops, cuadruplicando la potencia de su predecesor Guacolda.

Especificaciones técnicas

- 7.360 núcleos de procesamiento distribuidos en 29 nodos

- 24.320 GB de memoria RAM DDR5

- 12 GPU AMD Instinct MI210, con 79.872 procesadores stream

- Red InfiniBand NDR con ancho de banda de 400 Gbps

- 4 PB de almacenamiento IBM ESS 3200 compartido

- Inversión: 1.150 millones de pesos chilenos (950 millones de ANID y 200 millones de la U. de Chile)

Los casos de uso van desde simulaciones climáticas del Centro de Ciencia del Clima y la Resiliencia (CR2) hasta investigaciones en nanoelectrónica mediante DFT,.

La frontera actual: La computación a Exaescala

La computación a exaescala representa el hito más reciente en supercomputación, definida como la capacidad de realizar al menos 1 exaflop o 10¹⁸ operaciones de coma flotante por segundo.

Este salto superlativo es mil veces superior a la era petaescala (10¹⁵ FLOPS), implica una transformación cualitativa: pasar de la simulación aproximada a la predicción de alta fidelidad, donde los modelos computacionales replican la complejidad del mundo real.

El impacto de la computación a exaescala no se limita a la velocidad, sino que abre aplicaciones que antes eran inviables. Su desafío central es el consumo energético, con supercomputadoras que requieren decenas de megavatios, lo que hace que la métrica FLOPS por vatio sea tan relevante como el rendimiento máximo.

Aplicaciones de la exaescala:

- Medicina personalizada: simulaciones moleculares y diseño de fármacos a nivel atómico.

- Genómica: análisis de secuenciación masiva y predicción de mutaciones.

- Modelos climáticos globales: simulaciones atmosféricas y oceánicas con resolución de kilómetros.

- Predicción de desastres naturales: terremotos, tsunamis y huracanes en tiempo real.

- Diseño de materiales avanzados: simulación de superconductores y compuestos cuánticos.

- Fusión nuclear: modelado del plasma en reactores tokamak y stellarators.

- Astrofísica: evolución de galaxias, agujeros negros y ondas gravitacionales.

- IA a gran escala: entrenamiento de modelos con billones de parámetros y simulaciones de lenguaje natural.

- Computación cuántica híbrida: emulación de circuitos cuánticos para validar hardware real.

- Defensa y seguridad: criptografía post-cuántica y simulaciones de escenarios estratégicos.

- Energía: optimización de redes eléctricas inteligentes y modelado de reactores nucleares.

- Movilidad autónoma: simulación masiva de escenarios urbanos para flotas de vehículos.

Los Titanes de la Exaescala

La lista TOP500, que clasifica dos veces al año a las supercomputadoras más potentes, documenta cómo la barrera del exaflop fue oficialmente superada en 2022. Según el ranking de junio de 2025, los sistemas líderes son:

- El Capitan (EE. UU. – LLNL): 1,742 exaFLOPS con arquitectura AMD EPYC + AMD Instinct, consumo de 29.581 kW.

- Frontier (EE. UU. – ORNL): 1,353 exaFLOPS, pionero en superar la barrera del exaflop.

- Aurora (EE. UU. – ANL): 1,012 exaFLOPS con Intel Xeon Max + Intel Max GPU.

Estos sistemas revelan tres tendencias fundamentales: el dominio de las arquitecturas híbridas CPU+GPU, la concentración geográfica en laboratorios nacionales estadounidenses, y la creciente importancia de la eficiencia energética como eje de competencia tecnológica.