La computación exaescala, hoy por hoy, representa el máximo nivel de potencia bruta que puede alcanzar la HPC (computación de alto rendimiento). Y desde el punto de vista científico, corresponde a un cambio cultural en cómo se hace ciencia.

Computación exaescala: un nuevo paradigma científico

La computación exaescala representa el máximo nivel alcanzado en potencia de cálculo dentro de la supercomputación. En este segmento se ubican únicamente los sistemas más veloces del planeta, evaluados y clasificados en el ranking TOP500 que elabora la Universidad de Tennessee.

Se define como la capacidad de un sistema para ejecutar al menos un quintillón (10^18) de operaciones de punto flotante de doble precisión por segundo (FP64), conocidas como FLOPS.

Este nivel corresponde al estándar de la industria científica. La doble precisión (64 bits) es indispensable para garantizar exactitud y estabilidad en simulaciones de gran escala, desde el modelado molecular hasta los sistemas astrofísicos.

Nota editorial: el punto flotante es una forma de representar números decimales en los computadores. Su ventaja es que permite manejar valores extremadamente grandes o muy pequeños de manera eficiente, lo que resulta esencial para la investigación científica.

Una analogía simple es pensar en la notación científica: escribir 3,2 × 10^8 en lugar de 320.000.000. Del mismo modo, el punto flotante permite a las supercomputadoras operar con números complejos sin perder precisión ni memoria.

La simulación como tercer pilar científico

La barrera de la exaescala consolidó la simulación como el tercer pilar de la ciencia, junto a la teoría y la experimentación. Esto significa que los investigadores ya no dependen únicamente de modelos simplificados o pruebas de laboratorio.

Hoy los investigadores pueden:

- Construir gemelos digitales de sistemas completos, desde células hasta el clima global.

- Pasar de modelos aproximados a simulaciones fieles que revelan nuevas dinámicas.

El salto frente a la petaescala es enorme: un sistema exaescala es unas mil veces más potente que sus predecesores.

Una forma de dimensionarlo: si los 8 mil millones de habitantes del planeta resolvieran un cálculo por segundo sin descanso durante más de cuatro años, recién igualarían lo que un superPC como Frontier logra en un segundo del ranking TOP500.

Petaescala y exaescala en la ciencia

Hay que destacar que con la petaescala se podían hacer simulaciones de sistemas complejos como: dinámica molecular, comportamiento de materiales, astrofísica, simulaciones nucleares, pero con algunas limitaciones:

- Los modelos debían simplificarse para poder correr en tiempo razonable.

- Se trabajaba con resoluciones más bajas: en clima, por ejemplo, mallas de decenas de kilómetros; en biología, moléculas pequeñas o porciones de sistemas celulares.

- Muchas interacciones quedaban fuera porque la potencia no alcanzaba.

Lo que cambia con la llegada de la exaescala no es que “recién ahora se pueda simular”, sino que la fidelidad y el alcance de las simulaciones se multiplican. Esto permite:

- Gemelos digitales completos: una célula entera, el clima global a resolución de 1 km, o incluso un reactor nuclear detallado.

- Más física y más química en los modelos: por ejemplo, ya no solo gravedad en cosmología, sino también la física de bariones (materia ordinaria).

- Escalas temporales más largas: simular procesos que antes duraban minutos, ahora puede extenderse a años o milenios virtuales.

A inicios de los años 2000, la simulación como tal era un complemento de la teoría y la experimentación. Con la llegada de la petaescala, la simulación permitía entender mejor los sistemas complejos, y hoy la exaescala se consolida como un método autónomo, funcionando como un verdadero laboratorio digital en el que es posible realizar experimentos imposibles en la realidad.

A grandes rasgos, la exaescala permite:

- También posibilita correr cientos de escenarios climáticos en paralelo, ampliando la capacidad de anticipar fenómenos globales.

- Ya no se trata de “una aproximación útil”, sino de un espacio computacional capaz de reproducir sistemas completos.

- Permite, por ejemplo, probar millones de combinaciones de moléculas para el desarrollo de fármacos.

Arquitectura tecnológica: los tres pilares de la exaescala

El rendimiento real de la computación exaescala no depende solo de alcanzar la máxima velocidad teórica. Se sostiene en un ecosistema equilibrado de hardware y software, concebido de manera conjunta para funcionar como una unidad integrada.

Este ecosistema descansa en tres pilares interdependientes:

- Computación masiva

- Manejo de datos extremo

- Convergencia con inteligencia artificial.

Computación masiva: potencia bruta heterogénea

La base de la exaescala es una arquitectura heterogénea, lo que significa que el sistema no usa un único tipo de procesador, sino que combina diferentes arquitecturas que se complementan.

Estos sistemas combinan procesadores centrales (CPUs) de propósito general como los Intel Xeon Max Series, o los AMD Ryzen Threadripper, con varios aceleradores gráficos (GPUs) como laAMD Instinct MI300X, Intel GPU Data Center Max Series y la NVIDIA H200 , capaces de ejecutar operaciones en paralelo a una escala imposible para las CPUs por sí solas.

Analicemos el siguiente escenario:

- La CPU funciona como el arquitecto que diseña y supervisa la obra,

- Las GPUs son miles de albañiles que colocan ladrillos al mismo tiempo.

- El resultado es que la construcción se completa en un plazo récord gracias a la combinación de inteligencia y fuerza de trabajo masiva.

Por lo tanto, en exaescala, lo común es CPUs + GPUs:

- CPUs: muy buenas para tareas secuenciales, de control y coordinación.

- GPUs: excelentes para ejecutar millones de operaciones en paralelo (paralelismo masivo).

Esa combinación permite aprovechar lo mejor de cada procesador y alcanzar la escala de cálculo necesaria.

Manejo de datos extremo: el sistema nervioso

Este pilar comprende dos elementos críticos: la interconexión de latencia ultrabaja y el almacenamiento de nueva generación.

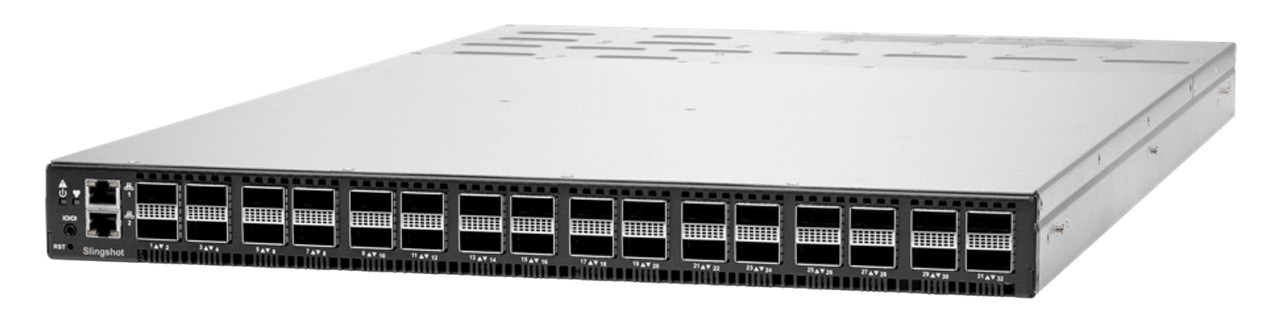

Interconexión de latencia ultrabaja: HPE Slingshot

La interconexión funciona como la red que enlaza todos los nodos de la supercomputadora. En Estados Unidos, el estándar es HPE Slingshot, capaz de escalar a 250.000 nodos:

- Puede mantener un máximo de tres saltos de red entre dos puntos

- Reduciendo la latencia.

- Incorpora gestión avanzada de congestión

- Gestión de enrutamiento adaptativo para redirigir los datos de manera dinámica.

Para SuperPCs como Aurora o El Capitán, HPE Slingshot es la arteria clave de conexión entre servidores, moviendo la data de un lado a otro, veamos la siguiente analogía:

- La interconexión es como una red de autopistas inteligentes en una megaciudad.

- Los datos son los camiones de reparto que circulan sin semáforos que los retrasen.

- Si aparece un atasco, las rutas se desvían automáticamente para garantizar la llegada al destino con la mayor velocidad posible.

Almacenamiento

Para alimentar millones de procesadores se necesita un sistema de archivos que evite los cuellos de botella. DAOS (Distributed Asynchronous Object Storage) resuelve este problema mediante metadatos totalmente distribuidos, eliminando la dependencia de un servidor central.

Desde una manera más simple, podemos pensar de este modo:

- Suponer que la supercomputadora es como una biblioteca del tamaño de un país.

- Un sistema tradicional obliga a todos los bibliotecarios a consultar un único fichero para encontrar un libro, creando enormes filas.

- DAOS, en cambio, da a cada bibliotecario una copia instantánea del fichero, lo que permite localizar cualquier libro sin esperas.

IA y simulación: Flujo unificado

El verdadero salto de la exaescala está en la integración de la simulación con la inteligencia artificial, lo que permite fusionar ambos enfoques en un mismo flujo de trabajo.

- Esto acelera los descubrimientos científicos al reducir tiempos y costos.

- No se ejecutan por separado, sino de manera unificada.

- La IA se entrena con los datos que producen las simulaciones.

- Los modelos resultantes actúan como sustitutos ultrarrápidos.

Como analogía, tomemos el diseño aeronáutico:

- la IA transforma el modo en que se desarrollan los modelos y ensayos.

- La simulación tradicional requiere construir miles de maquetas a escala.

- Cada una debe probarse en un túnel de viento, con un alto costo y lentitud.

- Con IA, bastan unas pocas pruebas iniciales para que el sistema aprenda las reglas de la aerodinámica.

- A partir de ese aprendizaje, la IA puede predecir el resultado de miles de diseños y sugerir directamente el óptimo.

Aplicaciones de la computación exaescala

La computación exaescala no es un ejercicio académico, sino una herramienta construida para abordar desafíos de la ciencia, la industria y la sociedad. Su capacidad está permitiendo avances en campos que antes estaban limitados por la potencia computacional.

Medicina de precisión y descubrimiento de fármacos 🧬

La exaescala está revolucionando la biomedicina al acelerar la búsqueda de nuevos tratamientos mediante simulaciones virtuales.

- Permite el cribado de miles de millones de compuestos moleculares en menos tiempo y a menor costo.

- La supercomputadora LUMI entrena redes neuronales para detectar cáncer en etapas tempranas.

- Simula la eficacia de los fármacos en pacientes individuales, clave para la medicina personalizada.

- En Aurora, proyectos se centran en el diseño rápido y efectivo de terapias innovadoras.

Ejemplos reales de uso:

- LUMI y ComPatAI: la supercomputadora europea se usa en el proyecto liderado por Pekka Ruusuvuori (Universidad de Turku) para procesar más de 2,5 millones de imágenes histológicas de cáncer de próstata y mama. La IA entrenada en LUMI detecta patrones invisibles al ojo humano, logrando diagnósticos más tempranos y precisos.

- EXSCALATE Platform: durante la pandemia de COVID-19, realizó screening virtual de más de 70 mil millones de moléculas contra proteínas del SARS-CoV-2. En 60 horas se ejecutaron más de un billón de evaluaciones, identificando compuestos como Raloxifene, que avanzó a ensayos clínicos de fase II.

Ciencia de materiales y energía limpia

El diseño “in silico” posibilita la creación de nuevos materiales directamente desde el nivel atómico, reduciendo la dependencia de pruebas físicas.

- Aurora se usa para investigar baterías más duraderas.

- Simulaciones exploran paneles solares más eficientes y catalizadores para hidrógeno.

- Este enfoque acorta el ciclo de innovación en tecnologías de energía limpia.

Veamos ejemplos del tema

- Simulaciones cuánticas de materiales: Aurora permite simulaciones 1.000 veces mayores en tamaño y velocidad que antes, acelerando el descubrimiento de materiales para baterías más duraderas, paneles solares más eficientes y catalizadores de hidrógeno.

- Aurora y catalizadores: en Argonne, el equipo de David Bross utiliza Aurora y la ecuación de Schrödinger para modelar catalizadores a nivel atómico y molecular. El objetivo es diseñar nuevos químicos y procesos para la producción de energía limpia.

Modelado climático y meteorológico

La exaescala permite generar simulaciones climáticas globales con resolución a escala de kilómetros, mejorando la precisión sin precedentes.

- Predicciones más exactas del cambio climático a largo plazo.

- Modelado detallado de fenómenos extremos como huracanes y sequías.

- Herramienta clave para la evaluación de riesgos y el diseño de estrategias de adaptación.

Ejemplos de la aplicación de la exaescala

- Destination Earth: LUMI ejecuta este proyecto de la Comisión Europea, que desarrolla un gemelo digital de la Tierra para evaluar impactos del cambio climático y estrategias de adaptación en escalas locales y regionales.

- ICEYE y monitorización ambiental: con LUMI, la empresa procesa en tiempo real datos de radar de microsatélites, generando imágenes precisas del terreno para detectar incendios, inundaciones y desastres naturales bajo cualquier condición climática.

Cosmología y los misterios del universo

La cosmología depende de simulaciones masivas para comprender la estructura del universo y la naturaleza de la materia oscura y la energía oscura.

- El código HACC en la supercomputadora Frontier alcanzó un rendimiento 300 veces superior al de referencia.

- Por primera vez se incorporó la física de los bariones junto a la gravedad en simulaciones cosmológicas.

- Esto permite estudiar la formación de galaxias con fidelidad inédita.

Ejemplos reales

- Frontier y el código HACC: alcanzó un rendimiento 300 veces superior al de referencia al usar unos 9.000 nodos de Frontier, produciendo la simulación astrofísica más grande jamás realizada.

- Simulaciones con física bariónica: Por primera vez, las simulaciones cosmológicas en exaescala incorporan no solo la gravedad y la materia oscura, sino también la física de los bariones, es decir, la materia ordinaria que forma estrellas, planetas y galaxias. El volumen simulado alcanza los 31 mil millones de megapársecs cúbicos, un nivel de detalle nunca visto en este campo.

«Necesitamos simular tanto la materia oscura como la materia convencional, junto con la gravedad y toda la física astrofísica».

Salman Habib, director de Ciencias Computacionales en Argonne

Los desafíos monumentales de la era de la supercomputación exaescala

La supercomputación no es solo hardware, el diseño de cada una de estas de bestias de cálculo tiene retos importantes, como el consumo energético, la complejidad de la programación y la fiabilidad en sistemas con millones de componentes.

Consumo energético

Los primeros sistemas exaescala demandan entre 20 y 40 megavatios, una cantidad equivalente al consumo de una ciudad pequeña. Esta magnitud convierte la eficiencia energética en un factor crítico.

- La métrica fundamental es el rendimiento expresado en gigaflops por vatio.

- Se han desarrollado sistemas de refrigeración líquida directa que permiten extraer calor de forma más eficiente que la refrigeración por aire.

- Optimizar la eficiencia no solo es una necesidad técnica, sino también económica, ya que el costo de operación puede alcanzar cifras de cientos de millones de dólares anuales.

Complejidad de la programación

Coordinar millones de núcleos heterogéneos —CPUs, GPUs y otros aceleradores— plantea un desafío sin precedentes para los desarrolladores. Ningún modelo de programación tradicional puede manejar por sí solo esta escala de paralelismo.

- MPI (Message Passing Interface): se utiliza para gestionar la comunicación entre nodos.

- OpenMP: permite paralelizar las tareas dentro de un mismo nodo.

- SYCL: proporciona un estándar moderno que habilita la programación de arquitecturas heterogéneas desde una única base de código, garantizando portabilidad.

Fiabilidad a escala masiva

En un sistema con millones de componentes, los fallos no son una posibilidad remota, sino una certeza estadística. El tiempo medio entre fallos (MTBF) en estas máquinas puede ser tan bajo como 30 minutos.

- Los sistemas deben incorporar estrategias de resiliencia y tolerancia a fallos para mantener la continuidad del trabajo.

- El mecanismo más utilizado es el checkpointing, que guarda periódicamente el estado de la simulación.

- De este modo, cuando ocurre un fallo, el sistema puede reiniciarse desde el último punto seguro, sin necesidad de repetir semanas de cálculo.