Cada vez los modelos de lenguaje de gran tamaño están siendo más críticos para todas las aristas de la tecnología, y Apple lo sabe bien, porque acaba de sellar un acuerdo con NVIDIA para acelerar estos procesos.

Hoy, Apple ha compartido los detalles de una colaboración con NVIDIA para mejorar considerablemente el rendimiento de los modelos de lenguaje de gran tamaño (LLM) mediante la implementación de una nueva técnica de generación de texto que ofrece mejoras sustanciales de velocidad para las aplicaciones de IA.

Recordemos que fue a principios de este año que Apple publicó y puso en código abierto el denominado Recurrent Drafter (ReDrafter). Este es un método que combina beam search y dynamic tree attention para acelerar la generación de texto.

Beam Search explora múltiples secuencias de texto potenciales a la vez para obtener mejores resultados, mientras que dynamic tree attention organiza y elimina los solapamientos redundantes entre estas secuencias para mejorar la eficiencia.

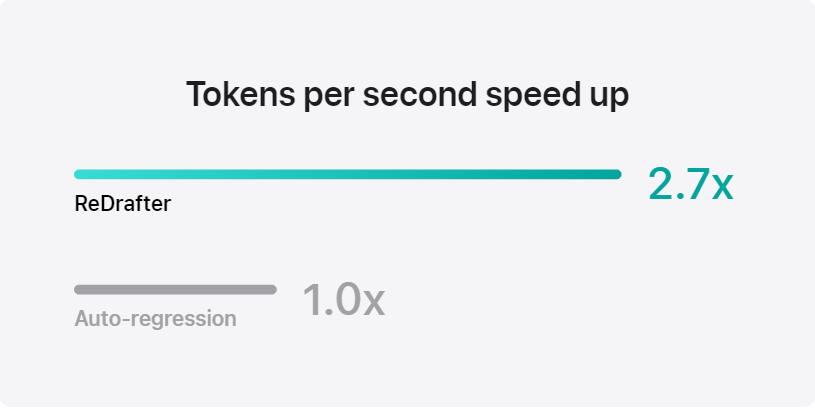

Apple ha integrado la tecnología en el marco TensorRT-LLM de NVIDIA, que optimiza los LLM que se ejecutan en las GPU NVIDIA, donde ha conseguido «un rendimiento puntero», según Apple. Y gracias a la integración, la técnica consiguió multiplicar por 2,7 la velocidad de generación de tokens por segundo durante las pruebas realizadas con un modelo de producción que contenía decenas de miles de millones de parámetros.