La firma estadounidense anunció la serie de GPU profesional AMD Instinct MI350, especialmente diseñada para la inteligencia artificial y la computación de alto rendimiento (HPC). Estas tarjetas no representan solo una actualización en cómputo, sino un salto significativo que busca competir con NVIDIA.

Lo que diferencia a esta serie es su arquitectura CDNA de cuarta generación, diseñada específicamente para cargas de trabajo de máxima exigencia, sin descuidar la eficiencia energética, que es un costo clave en los data centers.

¿Qué hace realmente especial a la nueva serie AMD Instinct MI350?

La nueva serie MI350 introduce dos modelos principales: MI350X y MI355X, cuyas características comunes son:

- La arquitectura CDNA de cuarta generación,

- Un proceso de fabricación de 4 nanómetros

- Memoria HBM3E de 288GB

Estas características garantizan un rendimiento sólido en cargas de trabajo exigentes.

Las diferencias más importantes están en el diseño del sistema de enfriamiento, el consumo energético y el factor de forma.

- El modelo MI350X está pensado para servidores estándar y ofrece un equilibrio entre potencia y flexibilidad

- El MI355X apuesta por configuraciones de alta densidad con enfriamiento líquido optimizado.

Estas variantes permiten que las organizaciones elijan la opción que mejor se ajuste a sus requerimientos operativos.

Los números que realmente importan

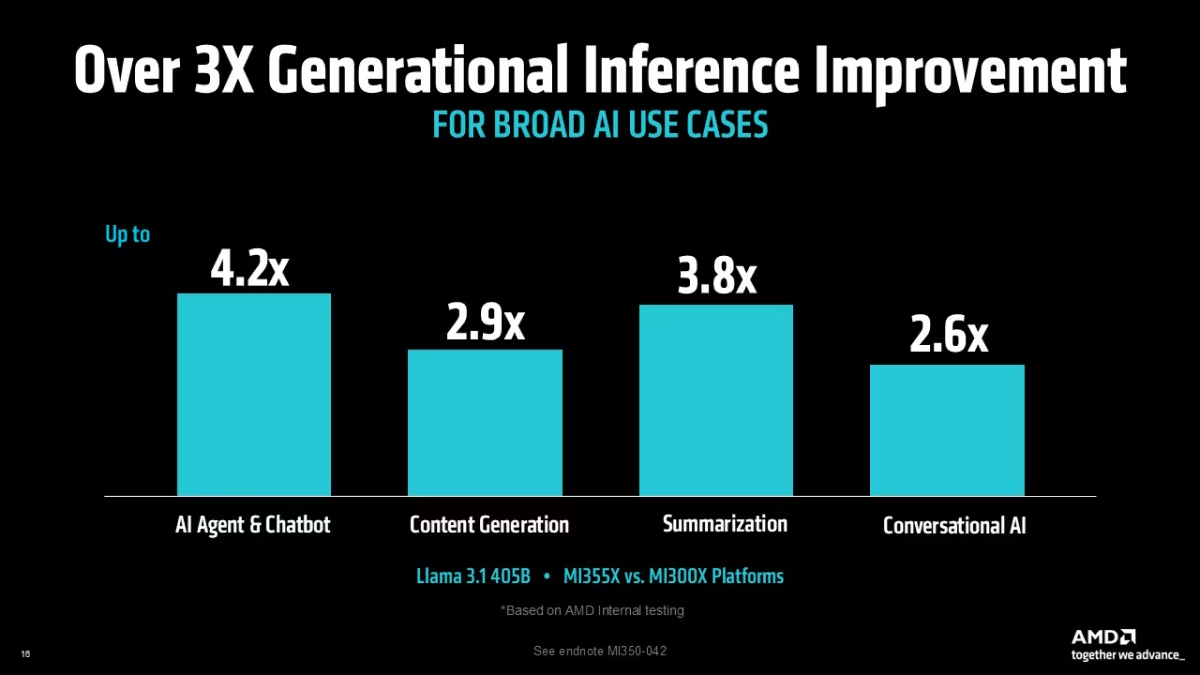

Cuando hablamos de rendimiento en IA, los números pueden ser una locura; sin embargo, los resultados de AMD con el modelo Llama 3.1 405B son difíciles de ignorar.

De acuerdo con las gráficas proporcionadas por AMD, se ven mejores desde 2.6X hasta 4.2X dependiendo de la aplicación, lo que en términos prácticos significa que tareas que antes tomaban horas ahora se completan en minutos.

Lo interesante aparece al comparar el MI355X contra las tarjetas B200 de Nvidia. Los resultados muestran una ventaja consistente, con un 1.3X mejor rendimiento en Llama 3.1 405B y un 1.2X en DeepSeek R1, cifras que en la práctica se traducen en respuestas más rápidas y mayor capacidad de procesamiento.

![Rendimiento de inferencia para modelos grandes [Gráfico comparativo mostrando throughput: DeepSeek R1 FP4: 1.2x, Llama 3.1 405B FP4: 1.3x, Llama 3.1 405B FP4: 1x]](https://static2.pisapapeles.net/uploads/2025/09/AMD-MI350-02.jpg)

Impacto en costos operativos y eficiencia con la AMD Instinct MI350

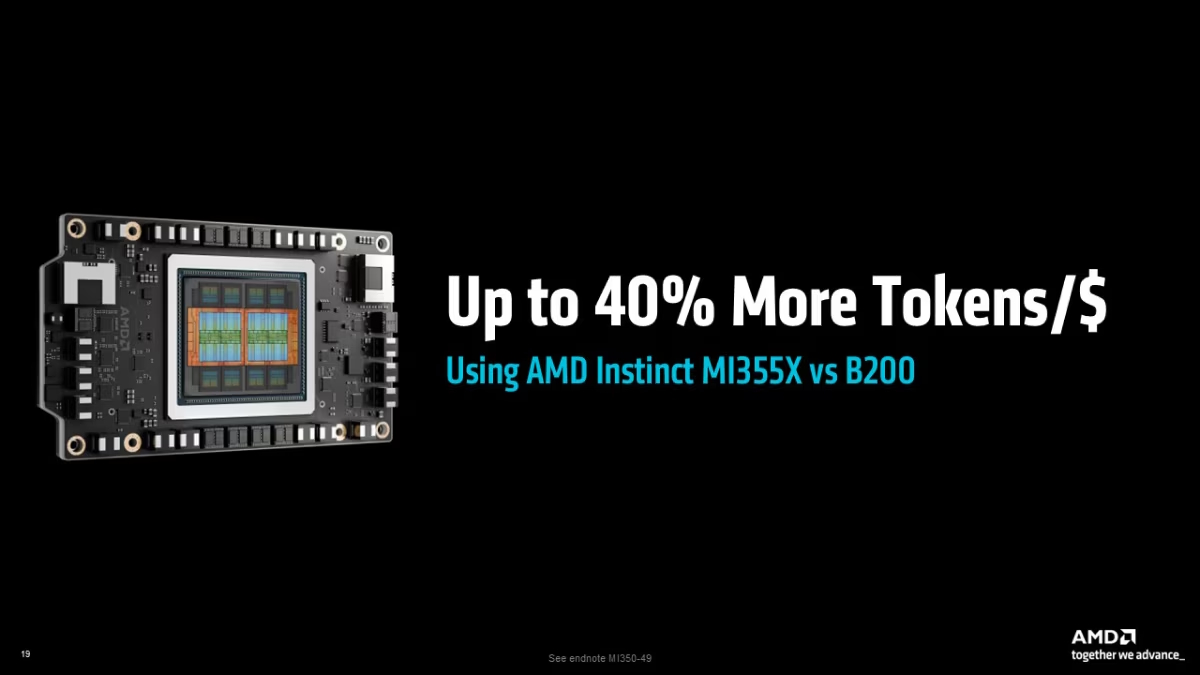

La compañía asegura que su MI355X puede procesar hasta un 40% más tokens por dólar en comparación con alternativas de Nvidia. En una industria donde los costos operativos pueden definir el éxito o fracaso de un proyecto de IA, esta métrica es determinante.

- En entrenamientos largos, los resultados muestran mejoras consistentes.

- Speedups de 1.13X en configuraciones time-to-train.

- Incremento de 1.12X en setups complejos con Llama 2-70B-LoRA.

- Aunque no son incrementos espectaculares, cada porcentaje es relevante.

- En modelos de gran escala, estas mejoras pueden significar miles de dólares en tiempo de GPU.

Estos números cobran importancia cuando se proyectan a gran escala. Para una empresa que procesa millones de consultas diarias, un ahorro del 40% en costos puede representar millones de dólares al año en términos operativos.